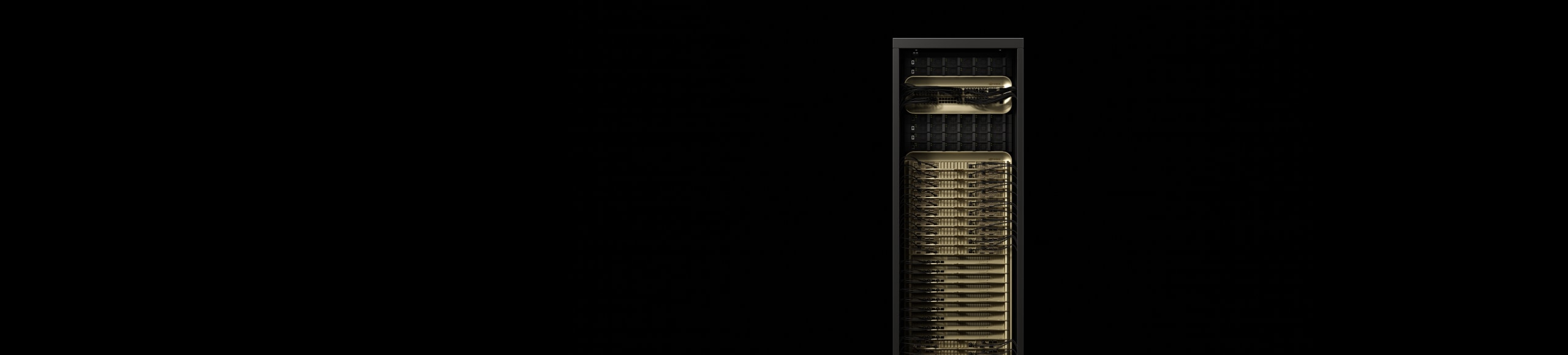

NVIDIA GB200 NVL72

La nuova era del computing.

Panoramica

Sbloccare modelli con miliardi di parametri in tempo reale

Il sistema NVIDIA GB200 NVL72 collega 36 CPU Grace e 72 GPU Blackwell in un design rack con raffreddamento a liquido. È dotato di un dominio NVLink™ a 72 GPU che funge da GPU singola e offre inferenza in tempo reale 30 volte più veloce su LLM con miliardi di parametri.

Il superchip GB200 Grace Blackwell è un componente essenziale del sistema NVIDIA GB200 NVL72, che collega due GPU NVIDIA Blackwell Tensor Core ad alte prestazioni e una CPU NVIDIA Grace™ tramite l'interconnessione NVLink-C2C alle due GPU Blackwell.

In evidenza

La super potenza dell'IA di nuova generazione e del computing accelerato

Inferenza ed efficienza energetica LLM: TTL = 50 millisecondi (ms) in tempo reale, FTL = 5 s, 32.768 input/1.024 output, NVIDIA HGX™ H100 in scala su InfiniBand (IB) rispetto a GB200 NVL72, training di 1,8 T MOE 4096x HGX H100 in scala su IB rispetto a 456 x GB200 NVL72 in scala su IB. Dimensioni cluster: 32.768

Carico di lavoro di aggregazione e unione nel database con compressione Snappy/Deflate derivata da query TPC-H Q4. Implementazione di query personalizzate per x86, H100 singola GPU e singola GPU da GB200 NLV72 rispetto a Intel Xeon 8480+

Prestazioni previste soggette a modifica.

NVIDIA GB200 NVL4

NVIDIA GB200 NVL4 apre il futuro dell'HPC e dell'IA convergenti, offrendo prestazioni rivoluzionarie attraverso un bridge che collega quattro GPU NVIDIA NVLink Blackwell unificate con due CPU Grace tramite l'interconnessione NVLink-C2C. Compatibile con i server modulari NVIDIA MGX™ raffreddati a liquido, offre prestazioni fino a 2 volte superiori rispetto alla generazione precedente per l'elaborazione scientifica, l'IA per la formazione scientifica e le applicazioni di inferenza.

Caratteristiche

Innovazioni tecnologiche

Fabbrica IA per la nuova rivoluzione industriale

NVIDIA Mission Control

NVIDIA Mission Control alimenta ogni aspetto delle operazioni della fabbrica IA basata su NVIDIA GB200 NVL72, dall'orchestrazione dei carichi di lavoro nel dominio NVLink a 72 GPU all'integrazione con le strutture. Offre agilità istantanea per l'inferenza e l'allenamento e fornendo intelligenza full-stack per la resilienza dell'infrastruttura. Ogni azienda può eseguire l'IA con efficienza a iperscalare, semplificando e accelerando la sperimentazione dell'IA.

Specifiche

Specifiche GB200 NVL72 Specs¹

| GB200 NVL72 | Superchip Grace Blackwell GB200 | |

| Configurazioni | 36 CPU Grace | 72 GPU Blackwell | 1 CPU Grace | 2 GPU Blackwell |

| NVFP4 Tensor Core2 | 1.440 | 720 PFLOPS | 40 | 20 PFLOPS |

| FP8/FP6 Tensor Core2 | 720 PFLOPS | 20 PFLOPS |

| INT8 Tensor Core2 | 720 POPS | 20 POPS |

| FP16/BF16 Tensor Core2 | 360 PFLOPS | 10 PFLOPS |

| TF32 Tensor Core | 180 PFLOPS | 5 PFLOPS |

| FP32 | 5.760 TFLOPS | 160 TFLOPS |

| FP64 / FP64 Tensor Core | 2.880 TFLOPS | 80 TFLOPS |

| Memoria della GPU | Larghezza di banda | 13,4 TB HBM3E | 576 TB/s | 372 GB HBM3E | 16 TB/s |

| Banda NVLink | 130 TB/s | 3,6 TB/s |

| Numero di core CPU | 2.592 Core Arm® Neoverse V2 | 72 Core Arm Neoverse V2 |

| Memoria della CPU | Larghezza di banda | 17 TB LPDDR5X | 14 TB/s | 480GB LPDDR5X | 512 GB/s |

|

1. Specifiche sparse | dense. |

||

NVIDIA GB300 NVL72

NVIDIA GB300 NVL72 si caratterizza per la sua architettura con raffreddamento a liquidi basata su rack che integra 72 GPU NVIDIA Blackwell Ultra e 36 CPU NVIDIA Grace™ basate su Arm® in una singola piattaforma pensata appositamente per attività di inferenza di test su larga scala e di ragionamento con IA. Le fabbriche IA accelerate da GB300 NVL72, che usano NVIDIA Quantum-X800 InfiniBand o Spectrum-X Ethernet, ConnectX-8 SuperNIC con la gestione di NVIDIA Mission Control, migliorano complessivamente fino a 50 volte le prestazioni di output della fabbrica IA rispetto alle piattaforme basate su NVIDIA Hopper.