NVLink e Switch NVLink

Amplie a malha de rede com comunicações de GPU para GPU de alta largura de banda para treinamento de IA, inferência e outras cargas de trabalho exigentes aceleradas por GPU em escala de rack.

A Necessidade de uma Interconexão de Escalabilidade Mais Rápida

Alcançar o mais alto desempenho para os modelos de IA mais recentes requer comunicações entre GPUs perfeitas e de alto rendimento em todo o rack de servidor. Com baixa latência, largura de banda de rede enorme e conectividade total, a sexta geração do NVIDIA NVLink™ e do NVLink Switch foi projetada para acelerar o treinamento e a inferência para raciocínio mais rápido e cargas de trabalho de IA baseada em agentes.

Maximize a Taxa de Transferência e o Tempo de Atividade do Sistema com o NVIDIA NVLink

O NVLink de sexta geração permite 3,6 TB/s de largura de banda por GPU para a plataforma NVIDIA Rubin, o dobro da largura de banda da geração anterior e mais de 14 vezes a largura de banda do PCIe Gen6. Arquiteturas em escala de rack, como o NVIDIA Vera Rubin NVL72, conectam 72 GPUs em uma topologia completa para um total de 260 TB/s, fornecendo largura de banda enorme para as comunicações all-to-all necessárias para treinamento e inferência das principais arquiteturas de modelos de mistura de especialistas. O NVLink 6 Switch também introduz novos recursos de gerenciamento e resiliência projetados para maximizar o tempo de atividade do sistema, incluindo resiliência do plano de controle, a capacidade de operar com um rack parcialmente preenchido e a troca a quente de bandejas de switches.

Desempenho do NVLink

O NVIDIA NVLink de sexta geração no NVIDIA Rubin dobra a largura de banda de comunicação de GPU para GPU em comparação com a geração anterior para treinamento e inferência mais rápidos com as arquiteturas de modelos de IA mais recentes.

Aumente o Desempenho da GPU com Comunicações NVLink

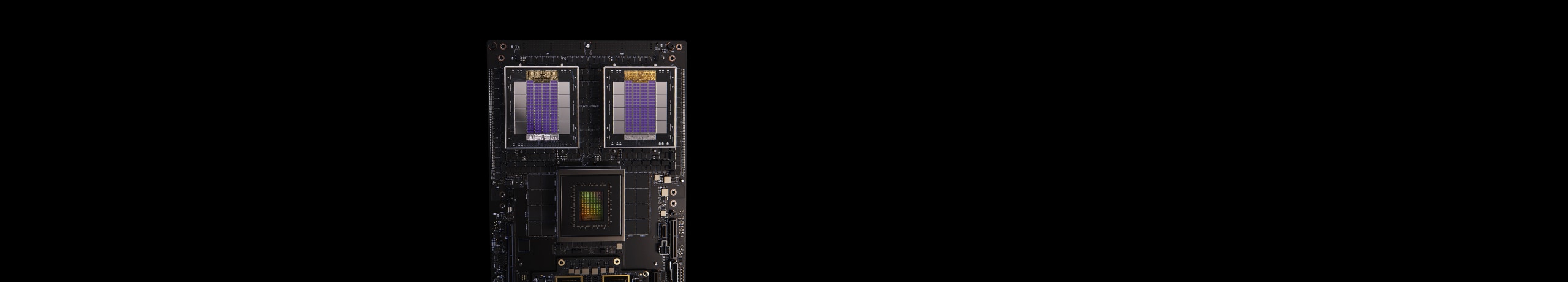

Conecte totalmente as GPUs com o NVIDIA NVLink e o switch NVLink

O NVLink é uma interconexão bidirecional e direta de GPU para GPU de 3,6 TB/s que dimensiona a entrada e a saída (IO) de várias GPUs em um servidor. Os chips de switch NVIDIA NVLink conectam vários NVLinks para fornecer comunicação entre todas as GPUs em velocidade total do NVLink em todo o rack.

Para permitir operações coletivas de alta velocidade, cada switch NVLink possui mecanismos para o Protocolo de Agregação e Redução Hierárquica Escalonável (SHARP - Scalable Hierarchical Aggregation and Reduction Protocol)™ para reduções em rede e aceleração multicast.

Acelere o Raciocínio no Tempo de Teste para Modelos com Trilhões de Parâmetros com o Sistema de Switch NVLink

Com o Switch NVLink, as conexões NVLink podem ser estendidas entre nós para criar um cluster de GPUs integrado e de alta largura de banda, de múltiplos nós, formando efetivamente uma GPU em escala de data center. O Switch NVIDIA NVLink permite 260 TB/s de largura de banda de GPU em um NVIDIA Vera Rubin NVL72 para paralelismo de modelos grandes. Clusters de vários servidores com NVLink dimensionam as comunicações de GPU proporcionalmente ao aumento da capacidade de computação, permitindo que o NVIDIA Vera Rubin NVL72 suporte até 9 vezes mais GPUs em comparação com um único sistema de oito GPUs.

NVIDIA NVLink Fusion

O NVIDIA NVLink™ Fusion oferece desempenho líder do setor em aumento e expansão de IA com a tecnologia NVIDIA, além de ASICs ou CPUs semipersonalizados, permitindo que os hiperescaladores criem uma infraestrutura de IA híbrida ASIC com tecnologia NVIDIA NVLink e arquitetura em escala de rack.

Dimensionamento da Empresa para Exascala

Conexão Total para Desempenho Incomparável

O chip de Switch NVLink no Vera Rubin NVL72 permite 72 GPUs totalmente conectadas em uma malha de computação sem bloqueio. O Switch NVLink interconecta todos os pares de GPUs a uma taxa incrível de 3,6 TB/s. Ele é compatível com comunicação completa de todos para todos. As 72 GPUs do Vera Rubin NVL72 podem ser usadas como um único acelerador de alto desempenho com até 3,6 exaFLOPS de potência de computação de IA.

A Plataforma Mais Poderosa de IA e HPC

O NVLink e o switch NVLink são componentes essenciais da solução completa de data center da NVIDIA, que incorpora hardware, rede, software, bibliotecas, modelos e aplicações de IA otimizadas do pacote de software NVIDIA AI Enterprise e do catálogo NVIDIA NGC™. A plataforma de ponta mais potente de IA e HPC permite que os pesquisadores forneçam resultados reais e implantem soluções na produção, gerando uma aceleração sem precedentes em todas as escalas.

Especificações

-

NVLink

-

Switch NVLink

| Terceira Geração | Quarta Geração | Quinta Geração | |

|---|---|---|---|

| NVLink por GPU | 600GB/s | 900GB/s | 1,800GB/s |

| Número Máximo de Links por GPU | 12 | 18 | 18 |

| Arquiteturas NVIDIA Suportadas | Arquitetura NVIDIA Ampere | Arquitetura NVIDIA Hopper™ | Arquitetura NVIDIA Blackwell |

| NVLink 3 Switch | NVLink 4 Switch | NVLink 5 Switch | |

|---|---|---|---|

| Número de GPUs com conexão direta dentro de um domínio NVLink | Até 8 | Até 8 | Até 576 |

| Largura de Banda Agregada Total | 600GB/s | 900GB/s | 1,800GB/s |

| Total aggregate bandwidth | 4.8TB/s | 7.2TB/s | 130TB/s |

| Arquiteturas NVIDIA Suportadas | Arquitetura NVIDIA Ampere | Arquitetura NVIDIA Hopper™ | Arquitetura NVIDIA Blackwell |

Especificações preliminares podem estar sujeitas a alterações.

NVIDIA Blackwell Ultra Delivers up to 50x Better Performance and 35x Lower Cost for Agentic AI

Built to accelerate the next generation of agentic AI, NVIDIA Blackwell Ultra delivers breakthrough inference performance with dramatically lower cost. Cloud providers such as Microsoft, CoreWeave, and Oracle Cloud Infrastructure are deploying NVIDIA GB300 NVL72 systems at scale for low-latency and long-context use cases, such as agentic coding and coding assistants.

This is enabled by deep co-design across NVIDIA Blackwell, NVLink™, and NVLink Switch for scale-out; NVFP4 for low-precision accuracy; and NVIDIA Dynamo and TensorRT™ LLM for speed and flexibility—as well as development with community frameworks SGLang, vLLM, and more.

Explore a fundo a plataforma NVIDIA Rubin.