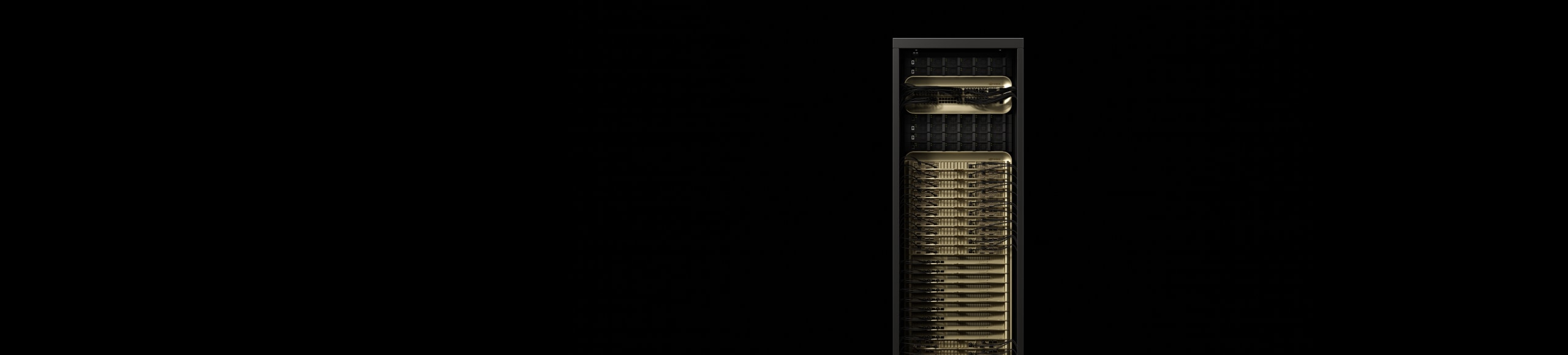

NVIDIA GB200 NVL72

생성형 AI의 새로운 시대를 지원합니다.

실시간 1조 개 매개 변수 모델 활용

72개 GPU가 하나의 거대한 GPU처럼 작동하는 NVIDIA NVLink™ 도메인을 갖추고 있으며, 이 도메인은 실시간 조 단위 매개변수 LLM(거대 언어 모델) 추론을 30배 더 빠르게 제공하고, MoE(전문가 혼합) 아키텍처에서 10배 향상된 성능을 구현합니다.

GB200 Grace Blackwell 슈퍼칩은 NVIDIA GB200 NVL72의 핵심 구성 요소로, 2개의 고성능 NVIDIA Blackwell Tensor 코어 GPU와 NVIDIA Grace™ CPU를 NVLink-C2C 인터커넥트를 통해 2개의 Blackwell GPU에 연결합니다.

하이라이트

차세대 AI 및 가속 컴퓨팅 강화

LLM 추론 및 에너지 효율성: TTL = 50밀리초(ms) 실시간, FTL = 5초, 32,768 입력/1,024 출력, NVIDIA HGX™ H100 스케일 오버 InfiniBand(IB) 대 GB200 NVL72, 훈련 1.8T MOE 4096x HGX H100 스케일 오버 IB 대 456x GB200 NVL72 스케일 오버 IB. 클러스터 크기: 32,768

TPC-H Q4 쿼리에서 파생된 스내피/디플레이트 압축을 사용한 데이터베이스 병합 및 집계 워크로드. x86, H100 단일 GPU 및 GB200 NLV72의 단일 GPU와 Intel Xeon 8480+에 대한 사용자 맞춤형 쿼리 구현 비교

예상 성능은 변경될 수 있습니다.

NVIDIA GB200 NVL4

NVIDIA GB200 NVL4는 NVLink-C2C 상호 연결을 통해 2개의 Grace CPU와 4개의 NVIDIA NVLink Blackwell GPU를 통합하는 브릿지 구조로, HPC와 AI 융합 컴퓨팅의 미래를 열며 혁신적인 성능을 제공합니다. 액체 냉각식 NVIDIA MGX™ 모듈형 서버와 호환되는 이 제품은 과학 컴퓨팅, 과학 연구용 AI 학습 및 추론 애플리케이션에서 이전 세대 대비 최대 2배의 성능을 제공합니다.

특징

기술 혁신

새로운 산업 혁명을 위한 AI 팩토리

사양

GB200 NVL72 사양¹

| GB200 NVL72 | GB200 Grace Blackwell 슈퍼칩 | |

| 컨피규레이션 | 36 Grace CPU | 72 Blackwell GPU | 1 Grace CPU | 2 Blackwell GPU |

| FP4 코어2 | 1,440 | 720 PFLOPS | 40 | 20 PFLOPS |

| FP8/FP6 코어2 | 720 플롭스 | 20PFLOPS |

| INT8 Tensor 코어2 | 720 POPS | 20POPS |

| FP16/BF16 Tensor 코어2 | 360 PFLOPS | 10PFLOPS |

| TF32 Tensor 코어2 | 180 PFLOPS | 5PFLOPS |

| FP32 | 5,760 TFLOPS | 160 TFLOPS |

| FP64 / FP64 Tensor 코어 | 2,880 TFLOPS | 80 TFLOPS |

| GPU 메모리 대역폭 | 최대 13.4TB HBM3e | 576TB/s | 최대 372GB HBM3e | 16TB/s |

| NVLink 메모리 대역폭 | 130Tb/s | 3.6TB/s |

| CPU 코어 수 | 2592 Arm® Neoverse V2 코어 | 72 Arm Neoverse V2 코어 |

| CPU 메모리 대역폭 | 최대 17TB LPDDR5X | 최대 14TB/s | 최대 480GB LPDDR5X | 최대 512GB/s |

|

1. 희소 | 밀도 사양. |

||

NVIDIA GB300 NVL72

NVIDIA GB300 NVL72는 72개의 NVIDIA Blackwell Ultra GPU와 36개의 Arm® 기반 NVIDIA Grace™ CPU를 단일 플랫폼에 통합한 완전 액체 냉각식 랙 스케일 아키텍처를 갖추고 있으며, 테스트 시점 확장 추론과 AI 추론 작업을 위해 특별히 설계되었습니다. NVIDIA Quantum-X800 InfiniBand 또는 Spectrum-X 이더넷, ConnectX-8 SuperNIC, NVIDIA Mission Control 관리 기능을 활용해 GB300 NVL72로 가속화된 AI 팩토리는 NVIDIA Hopper 기반 플랫폼 대비 최대 50배 향상된 AI 팩토리 출력 성능을 제공합니다.