Switch NVLink y NVLink

Estructura de redes escalable con comunicaciones de GPU a GPU de alto ancho de banda para entrenamiento de IA, inferencia y otras cargas de trabajo exigentes a escala de rack aceleradas por GPU.

La Necesidad de una Interconexión de Escalabilidad Más Rápida

Alcanzar el más alto desempeño para los últimos modelos de IA requiere comunicaciones de GPU a GPU fluidos, eficientes y de alto rendimiento en todo el bastidor de servidores. Con baja latencia, un ancho de banda de red masivo y una conectividad integral, NVIDIA NVLink™ de sexta generación y NVLink Switch están diseñados para acelerar el entrenamiento y la inferencia, logrando un razonamiento más rápido y cargas de trabajo de IA más ágiles.

Maximice el Rendimiento y el Tiempo de Actividad del Sistema con NVLink de NVIDIA

NVLink de sexta generación permite 3,6 TB/s de ancho de banda por GPU para la plataforma NVIDIA Rubin, lo que proporciona el doble de ancho de banda que la generación anterior y es 14 veces mayor que PCIe Gen6. Las arquitecturas a escala de rack como NVIDIA Vera Rubin NVL72 conectan 72 GPU en una topología de todos a todos para un total de 260 TB/s, lo que proporciona un ancho de banda masivo para las comunicaciones de todos a todos necesarias para el entrenamiento y la inferencia de arquitecturas de modelos líderes de combinación de expertos. NVLink 6 Switch también presenta nuevas características de administración y resiliencia diseñadas para maximizar el tiempo de actividad del sistema, incluida la resiliencia del plano de control, la capacidad de ejecutarse con un bastidor parcialmente poblado y el intercambio en caliente de bandejas de switches.

Rendimiento NVLink

En comparación con la generación anterior, NVLink de NVIDIA de sexta generación en NVIDIA Rubin aumenta el ancho de banda de comunicación de GPU a GPU por 2 veces, lo que permite un entrenamiento e inferencia más rápidos con las últimas arquitecturas de modelos de IA.

Aumente el Rendimiento de la GPU con Switches NVLink

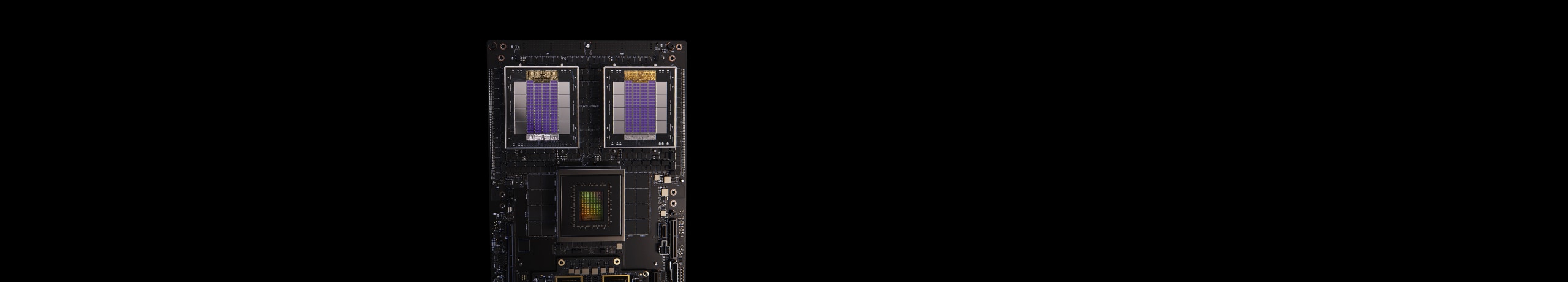

Conecte Completamente las GPU con NVLink de NVIDIA y Switch NVLink

NVLink es una interconexión bidireccional y directa de GPU a GPU de 3,6 TB/s que escala la entrada y salida (IO) de múltiples GPU dentro de un servidor. Los chips de switch NVLink de NVIDIA conectan múltiples NVLinks para ofrecer comunicación de GPU a GPU a la velocidad completa de NVLink en todo el rack.

Para permitir operaciones colectivas de alta velocidad, cada switch NVLink tiene motores para Agregación Jerárquica Escalable y Protocolo de Reducción (SHARP)™ de NVIDIA para reducciones en la red y aceleración multicast.

Acelere el Razonamiento en el Tiempo de Prueba para Modelos de Billones de Parámetros con el Sistema de Switches NVLink.

Con NVLink Switch es posible extender las conexiones de NVLink a todos los nodos para crear un clúster de GPU de múltiples nodos de manera fluida, eficiente y con un alto ancho de banda, con lo cual se forma efectivamente una GPU del tamaño de un data center. El switch NVLink de NVIDIA permite 260 TB/s de ancho de banda de GPU en una NVIDIA Vera Rubin NVL72 para el paralelismo de grandes modelos. Los clústeres de varios servidores con NVLink escalan las comunicaciones de GPU siguiendo el ritmo del aumento de la computación, por lo que NVIDIA Vera Rubin NVL72 puede admitir 9 veces más GPU, en comparación con un solo sistema de ocho GPU.

NVIDIA NVLink Fusion

NVLink de NVIDIA Fusion ofrece un desempeño líder en la industria para la escalabilidad y expansión de IA con tecnología de NVIDIA, además de ASIC o CPU semipersonalizados, lo que permite a los hiperescaladores desarrollar una infraestructura híbrida de IA ASIC con la tecnología NVLink de NVIDIA y una arquitectura a escala de rack.

Escalando de la Empresa a la Exaescala

Conexión Completa para un Rendimiento Incomparable

El chip NVLink Switch de Vera Rubin NVL72 permite 72 GPU completamente conectadas en una estructura de computación no bloqueante. El switch NVLink interconecta todos los pares de GPU a una increíble tasa de 3,6 TB/s. Admite una comunicación completamente multidireccional. Las 72 GPU en Vera Rubin NVL72 se pueden usar como un solo acelerador de alto rendimiento con hasta 3,6 exaFLOPS de potencia de computación de IA.

La Plataforma de IA y HPC Más Potente

NVLink y Switch NVLink son componentes esenciales de la solución completa para data centers de NVIDIA, que incluye hardware, redes, software, bibliotecas y modelos y aplicaciones de IA optimizados del paquete de software NVIDIA AI Enterprise y del catálogo NVIDIA NGC™. La plataforma de IA y HPC integral más potente permite a los investigadores ofrecer resultados del mundo real e implementar soluciones en la producción, lo que impulsa una aceleración sin precedentes a todos los niveles.

Especificaciones

-

NVLink

-

Switch NVLink

| Segunda Generación | Tercera Generación | Cuarta Generación | |

|---|---|---|---|

| NVLink por GPU | 600GB/s | 900GB/s | 1,800GB/s |

| Número Máximo de Enlaces por GPU | 12 | 18 | 18 |

| Arquitecturas NVIDIA Compatibles | Arquitectura NVIDIA Ampere | Arquitectura NVIDIA Hopper™ | Arquitectura NVIDIA Blackwell |

| NVLink 3 Switch | NVLink 4 Switch | NVLink 5 Switch | |

|---|---|---|---|

| Número de GPU con conexión directa dentro de un dominio NVLink | Hasta 8 | Hasta 8 | Hasta 576 |

| NVSwitch de Ancho de Banda de GPU a GPU | 600GB/s | 900GB/s | 1,800GB/s |

| Ancho de Banda Agregado Total | 4.8TB/s | 7.2TB/s | 130TB/s |

| Arquitecturas NVIDIA Compatibles | Arquitectura NVIDIA Ampere | Arquitectura NVIDIA Hopper™ | Arquitectura NVIDIA Blackwell |

Especificaciones preliminares; puede estar sujeto a cambios.

NVIDIA Blackwell Ultra Delivers up to 50x Better Performance and 35x Lower Cost for Agentic AI

Built to accelerate the next generation of agentic AI, NVIDIA Blackwell Ultra delivers breakthrough inference performance with dramatically lower cost. Cloud providers such as Microsoft, CoreWeave, and Oracle Cloud Infrastructure are deploying NVIDIA GB300 NVL72 systems at scale for low-latency and long-context use cases, such as agentic coding and coding assistants.

This is enabled by deep co-design across NVIDIA Blackwell, NVLink™, and NVLink Switch for scale-out; NVFP4 for low-precision accuracy; and NVIDIA Dynamo and TensorRT™ LLM for speed and flexibility—as well as development with community frameworks SGLang, vLLM, and more.

Explore en profundidad la plataforma NVIDIA Rubin.