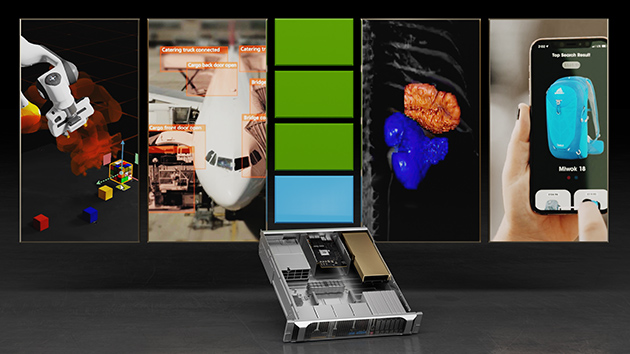

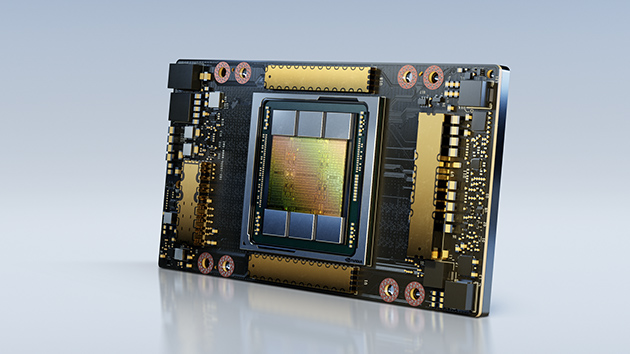

Les inférences d’IA servent à améliorer la qualité de vie des usagers du numérique en leur proposant des expériences intelligentes en temps réel, mais aussi à collecter des informations à haute valeur ajoutée à partir de milliards de capteurs et de caméras. Par rapport à des serveurs uniquement basés sur le traitement CPU, les serveurs Edge et les serveurs d’entrée de gamme équipés de GPU NVIDIA A2 Tensor Core offrent jusqu’à 20 fois plus de performances d’inférence, mettant instantanément à niveau n’importe quel serveur pour prendre en charge les applications d’IA modernes.

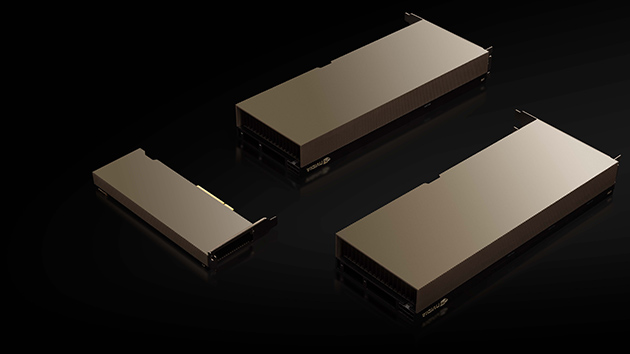

GPU NVIDIA A2 Tensor Core

GPU qui apporte les solutions d’IA de NVIDIA à tous les serveurs.