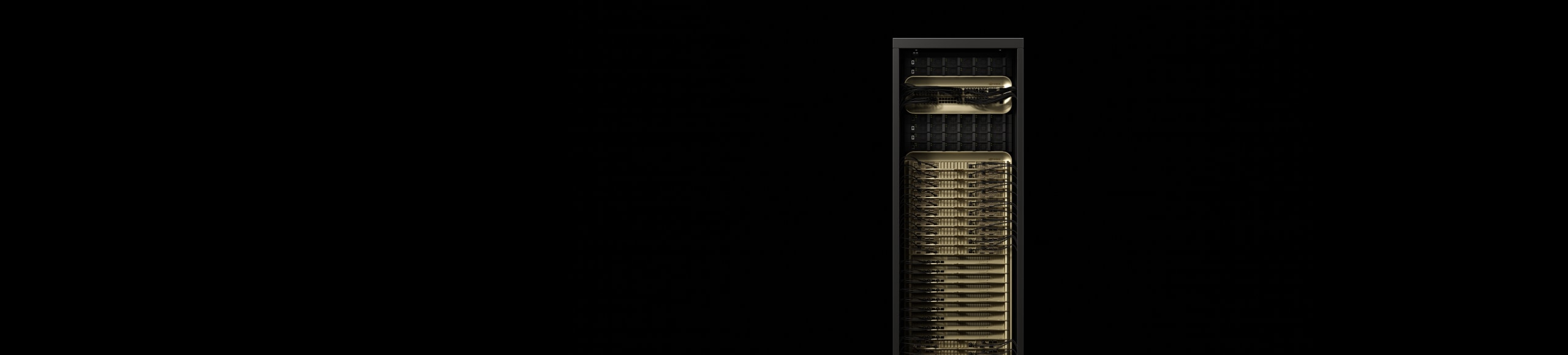

NVIDIA GB200 NVL72

驅動運算新時代

釋放即時兆級參數模型

它擁有一個由 72 個 GPU 組成的 NVIDIA NVLink™ 域,能夠作為單一、超大型 GPU 運作,並提供即時推論速度提升 30 倍、用於兆級參數的大型語言模型 (LLM),同時在混合專家 (MoE) 架構上達到 10 倍的效能提升。

GB200 Grace Blackwell 超級晶片是 NVIDIA GB200 NVL72 的關鍵元件,利用 NVLink-C2C 互連技術,將兩顆高效能 NVIDIA Blackwell Tensor 核心 GPU 與 NVIDIA Grace™ CPU,連接至兩顆 Blackwell GPU。

重點

大幅強化新一代人工智慧和加速運算

「LLM 推論與能源效率:TTL = 50 毫秒 (ms) 實際時間、FTL = 5 秒,32,768 個輸入/1,024 個輸出,比較透過 InfiniBand (IB) 擴充的 NVIDIA HGX™ H100 與 GB200 NVL72 訓練 1.8T MOE 的效能,其中比較的是透過 IB 擴充的 4096x HGX H100,以及透過 IB 擴充的 GB200 NVL72。叢集規模:32,768

採用源自 TPC-H Q4 查詢,採用 Snappy / Deflate 壓縮技術的資料庫聯結與彙總工作負載。GB200 NVL72 相較於 Intel Xeon 8480+,x86、H100 單一 GPU 與單一 GPU 的自訂查詢實作

此為預計效能,之後將有可能更新。

NVIDIA GB200 NVL4

NVIDIA GB200 NVL4 開啟融合式高效能運算與 AI 的未來發展,採用橋接方式,透過 NVLink-C2C 互連技術整合四顆 NVIDIA NVLink Blackwell GPU 與兩顆 Grace CPU,實現革命性的效能。這款產品與液冷式 NVIDIA MGX™ 模組化伺服器相容,相較於前一代,在科學運算、科學訓練 AI 與推論應用方面,效能最高提升 2 倍。

特色

技術突破

AI 工廠掀起全新產業革命

規格

GB200 NVL72 規格¹

| GB200 NVL72 | GB200 Grace Blackwell 超級晶片 | |

| 組成 | 36 顆 Grace CPU | 72 顆 Blackwell GPU | 1 顆 Grace CPU | 2 顆 Blackwell GPU |

| FP4 Tensor 核心2 | 1,440 | 720 PFLOPS | 40 | 20 PFLOPS |

| FP8/FP6 Tensor 核心2 | 720 PFLOPS | 20 PFLOPS |

| INT8 Tensor 核心2 | 720 POPS | 20 POPS |

| FP16/BF16 Tensor 核心2 | 360 PFLOPS | 10 PFLOPS |

| TF32 Tensor 核心2 | 180 PFLOPS | 5 PFLOPS |

| FP32 | 5,760 TFLOPS | 160 TFLOPS |

| FP64 / FP64 Tensor 核心 | 2,880 TFLOPS | 80 TFLOPS |

| GPU 記憶體頻寬 | 最高 13.4 TB HBM3e | 每秒 576 TB | 最高 372 GB HBM3e | 每秒 16 TB |

| NVLink 記憶體頻寬 | 每秒 130 TB | 每秒 3.6 TB |

| CPU 核心數 | 2592 個 Arm® Neoverse V2 核心 | 72 個 Arm Neoverse V2 核心 |

| CPU 記憶體頻寬 | 最高 17 TB LPDDR5X | 最高每秒 14 TB | 最高 480GB LPDDR5X | 最高每秒 512 GB |

|

1. 稀疏 | 密集的規格。 |

||

NVIDIA GB300 NVL72

NVIDIA GB300 NVL72 採用全液冷式機架規模架構,在單一平台整合 72 顆 NVIDIA Blackwell Ultra GPU 與 36 顆 Arm® 技術的 NVIDIA Grace™ CPU,是專為測試時擴充推論與 AI 推理任務而打造。GB300 NVL72 加速的 AI 工廠採用 NVIDIA Quantum-X800 InfiniBand 或 Spectrum-X 乙太網路、ConnectX-8 SuperNIC 以及 NVIDIA Mission Control 管理,相較於 NVIDIA Hopper 平台,AI 工廠輸出效能整體最高提升 50 倍。