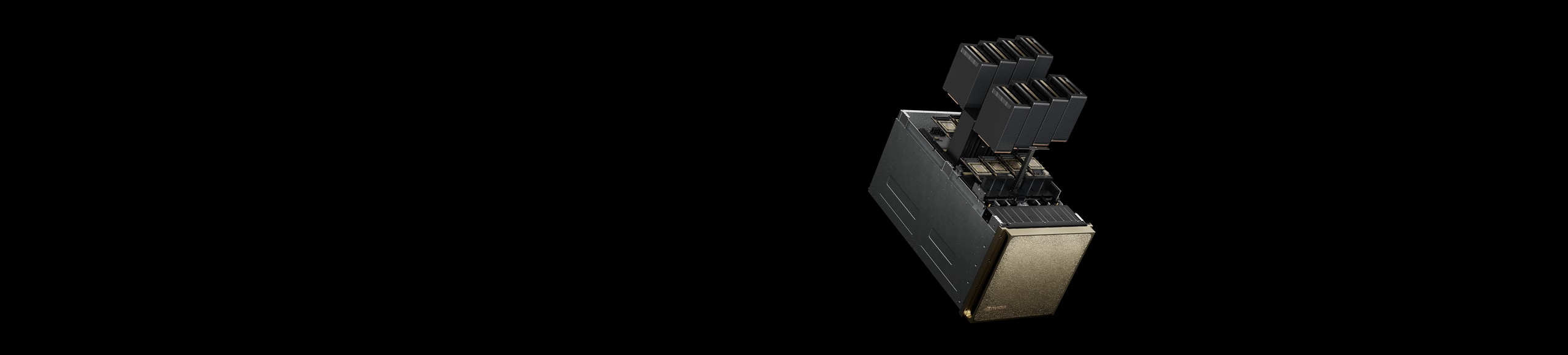

NVIDIA DGX B200

為您的 AI 工廠奠定基礎。

以進化式創新為後盾的革命性效能

NVIDIA DGX™ B200 是一個整合式的人工智慧平台,用於開發到部署的流程,適合在人工智慧旅程中任何階段且任何規模的企業。NVIDIA DGX B200 配備八顆與第五代 NVIDIA® NVLink™ 互連的 NVIDIA Blackwell GPU,相較於前一代系統,提供高達 3 倍的訓練效能和 15 倍的推論效能。 DGX B200 利用 NVIDIA Blackwell 架構,可處理各種工作負載,包括大型語言模型、推薦系統和聊天機器人,非常適合希望加速人工智慧轉型的企業。

優勢

整合式的 AI 工廠

效能

採用 NVIDIA DGX B200 的新一代效能

即時大型語言模型推論

此為預計效能,之後將有可能更新。權杖到權杖的延遲 (TTL) = 50 毫秒即時,第一個權杖的延遲 (FTL) = 5 秒,輸入序列長度 = 32,768,輸出序列長度 = 1,028,8 個八路 NVIDIA DGX H100 GPU 為氣冷式 GPU,相較於 1 個八路 NVIDIA® DGX B200 氣冷式,每顆 GPU 效能比較。

增強的 AI 訓練效能

此為預計效能,之後將有可能更新。32,768 個 GPU 規模、4,096 個 8 路 NVIDIA DGX H100 氣冷式叢集:400G IB 網路、4,096 個 8 路 NVIDIA DGX B200 氣冷式叢集:400G IB 網路。

規格

NVIDIA DGX B200 規格

| GPU | 8 顆 NVIDIA Blackwell GPU |

| GPU 記憶體 | 總計 1,440 GB,64 TB/s HBM3e 頻寬 |

| 效能 | FP4 Tensor 核心:144 PFLOPS | 72 PFLOPS* FP8 Tensor 核心:72 PFLOPS** |

| NVIDIA NVSwitch | 2個 |

| NVIDIA NVLink 頻寬 | 14.4 TB/s 聚合頻寬 |

| 電力消耗 | 最大 14.3 kW |

| CPU | 2 個 Intel® Xeon® Platinum 8570 處理器 總共 112 個核心,2.1 GHz(基本頻率) 4 GHz (最高加速) |

| 系統記憶體 | 2 TB,可擴充至 4 TB |

| 網路 | 4 個 OSFP 埠,對應 8 個單埠 NVIDIA® ConnectX-7 VPI

|

| 管理網路 | 10 Gb/s 板載網路介面卡(NIC),具備 RJ45 接頭 100 Gb/s 雙埠乙太網路 NIC 主機基板管理控制器 (BMC),配備 RJ45 |

| 儲存 | 作業系統:2x 1.9 TB NVMe M.2 內部儲存:8x 3.84 TB NVMe U.2 |

| 軟體 | NVIDIA AI Enterprise – 最佳化 AI 軟體 NVIDIA Mission Control – 運用 NVIDIA Run:ai 技術進行人工智慧資料中心操作與協調 NVIDIA DGX OS / Ubuntu – 作業系統 |

| 機架單位 | 10 RU |

| 系統尺寸 | 高度:17.5 in (444mm) 寬度:19.0 in (482.2mm) 長度:35.3 in (897.1 mm) |

| 工作溫度 | 10-35°C (50-90°F) |

| 企業支援 | 三年標準級硬體與軟體企業支援服務 |

|

*規格以稀疏 | 密集模式顯示 |

|

資源

為每家企業提供 AI 工廠

NVIDIA DGX SuperPOD

NVIDIA DGX SuperPOD™ 是一套一站式的人工智慧資料中心基礎架構解決方案,可為每位使用者和每個工作負載提供無與倫比的效能。 DGX SuperPOD 可透過任何 NVIDIA DGX 系統進行設定,提供領先業界的加速基礎架構,具可擴充效能,可用於最嚴峻的 AI 訓練和推論工作負載,並具備業界驗證的結果,讓 IT 能在不受影響的情況下提供效能。

隆重介紹 NVIDIA Mission Control

NVIDIA Mission Control 透過軟體提供世界級專業技術,精簡從工作負載到基礎架構的 AI 營運。這項軟體支援 NVIDIA Blackwell 資料中心,實現推論與訓練的即時敏捷性,同時提供全堆疊智慧,提升基礎架構韌性。所有企業都能夠以超大規模效率執行 AI,簡化並加速 AI 實驗流程。

將 NVIDIA DGX 平台的價值最大化

NVIDIA Enterprise Services 可為您的 NVIDIA DGX 基礎架構提供支援、教育與專業服務。在 AI 歷程的每一步都有 NVIDIA 專家支援,企業服務可助您快速、成功地啟動和執行專案。

NVIDIA DGX 客戶享有專屬訓練

瞭解 NVIDIA 深度學習機構 (DLI) 的人工智慧專家特別為NVIDIA DGX 客戶提供的專業技術訓練,如何實現尖端的人工智慧突破。

開始使用