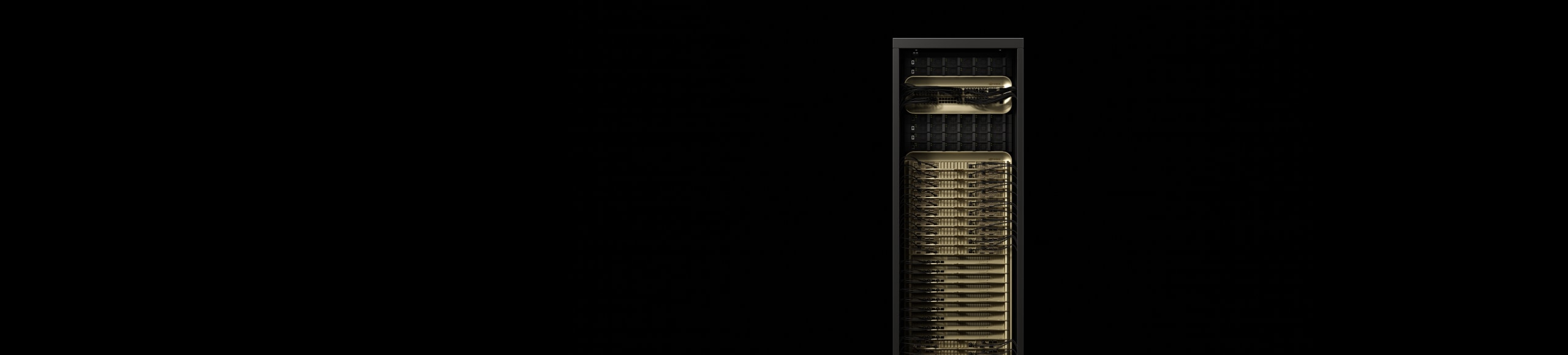

NVIDIA GB200 NVL72

Antrieb für das neue Zeitalter des intelligenten Edge-Computings.

Übersicht

Erschließung von Echtzeitmodellen mit Billionen Parametern

Der NVIDIA GB200 NVL72 verbindet 36 Grace-CPUs mit 72 Blackwell-GPUs in einem Rack-Design mit Flüssigkeitskühlung. Er verfügt über eine 72-GPU NVIDIA NVLink™-Domain, die als eine einzige, massive GPU fungiert und eine 30-mal schnellere Echtzeitinferenz für milliardenschwere Sprachmodelle (LLMs) ermöglicht.

Der GB200 Grace Blackwell Superchip ist eine Schlüsselkomponente des NVIDIA GB200 NVL72und verbindet zwei hochleistungsfähige NVIDIA Blackwell Tensor-Core-GPU und eine NVIDIA Grace™-CPU über die NVLink-C2C-Verbindung mit den beiden Blackwell-GPUs.

Highlights

Optimierung für KI und beschleunigtes Computing der nächsten Generation

LLM-Inferenz und Energieeffizienz: TTL = 50 Millisekunden (ms) Echtzeit, FTL = 5 s, 32.768 Eingang/1.024 Ausgang, NVIDIA HGX™ H100 skaliert über InfiniBand (IB) vs. GB200 NVL72, Training, 1,8T MOE 4096x HGX H100 skaliert über IB vs. 456x GB200 NVL72 skaliert über IB. Clustergröße: 32.768

Ein Datenbank-Join- und Aggregations-Workload mit Snappy/Deflate-Komprimierung, abgeleitet von einer TPC-HQ4-Abfrage. Benutzerdefinierte Abfrageimplementierungen für x86, H100 mit einem einzelnen Grafikprozessor und für einen einzelnen Grafikprozessor aus GB200 NLV72 vs. Intel Xeon 8480+

Die projizierte Leistung kann Änderungen unterliegen.

NVIDIA GB200 NVL4

Der NVIDIA GB200 NVL4 revolutioniert die Zukunft der integrierten HPC- und KI-Technologien, indem er eine außergewöhnliche Leistung durch die Verbindung von vier NVIDIA NVLink Blackwell-GPUs mit zwei Grace-CPUs über das NVLink-C2C-Interconnect liefert. In Verbindung mit flüssigkeitsgekühlten NVIDIA MGX™-modularen Servern ermöglicht er eine bis zu 2-fache Leistungssteigerung für wissenschaftliche Berechnungen, KI-Training für Wissenschaft sowie Inferenzanwendungen gegenüber der Vorgängergeneration.

Merkmale

Technologische Durchbrüche

KI-Fabrik für die neue industrielle Revolution

NVIDIA Mission Control

NVIDIA Mission Control steuert alle Aspekte der KI-Fabrikoperationen des NVIDIA GB200 NVL72, von der Orchestrierung der Workloads über die 72-GPU NVLink-Domain bis hin zur Integration mit den Einrichtungen. Es bietet sofortige Flexibilität für Inferenz und Training sowie Full-Stack-Intelligenz für die Ausfallsicherheit der Infrastruktur. Dank Mission Control können Unternehmen KI mit hyperskalierbarer Effizienz ausführen, was die schnelle Durchführung von KI-Experimenten unterstützt.

Technische Daten

GB200 NVL72 – Technische Daten¹

| GB200 NVL72 | GB200 Grace Blackwell Superchip | |

| Konfiguration | 36 Grace-CPU | 72 Blackwell-GPUs | 1 Grace CPU | 2 Blackwell-GPUs |

| NVFP4 Tensor-Core2 | 1.440 | 720 PFLOPS | 40 | 20 PFLOPS |

| FP8/FP6 Tensor-Recheneinheit2 | 720 PFLOPS | 20 PFLOPS |

| INT8-Tensor-Recheneinheit2 | 720 POPS | 20 POPS |

| FP16/BF16 Tensor-Recheneinheit2 | 360 PFLOPS | 10 PFLOPS |

| TF32 Tensor-Recheneinheit | 180 PFLOPS | 5 PFLOPS |

| FP32 | 5.760 TFLOPS | 160 TFLOPS |

| FP64/FP64 Tensor-Core | 2.880 TFLOPS | 80 TFLOPS |

| Grafikprozessorspeicher | Bandbreite | 13,4 TB HBM3e | 576 TB/s | 372 GB HBM3E | 16 TB/s |

| NVLink-Bandbreite | 130 TB/s | 3,6 TB/s |

| Anzahl der CPU-Recheneinheiten | 2.592 Arm® Neoverse V2-Recheneinheiten | 72 Arm® Neoverse V2-Recheneinheiten |

| CPU-Speicher | Bandbreite | 17 TB LPDDR5X | 14 TB/s | 480 LPDDR5X | 512 GB/s |

|

1. Spezifikation in spärlich | dicht. |

||

NVIDIA GB300 NVL72

NVIDIA GB300 NVL72 verfügt über eine komplett flüssigkeitsgekühlte KI-Infrastruktur im Rack-Maßstab mit 72 NVIDIA Blackwell Ultra GPUs und 36 Arm®-basierten NVIDIA Grace™ CPUs auf einer einzigen Plattform, die speziell für die Skalierung von Inferenz- und KI-Schlussfolgerungsaufgaben während der Testphase entwickelt wurde. KI-Fabriken, die mit GB300 NVL72 beschleunigt werden und NVIDIA Quantum-X800 InfiniBand oder Spectrum-X Ethernet, ConnectX-8 SuperNICs und NVIDIA Mission Control nutzen, bieten eine insgesamt bis zu 50-fache Steigerung der KI-Fabrikleistung im Vergleich zu NVIDIA Hopper-basierten Plattformen.