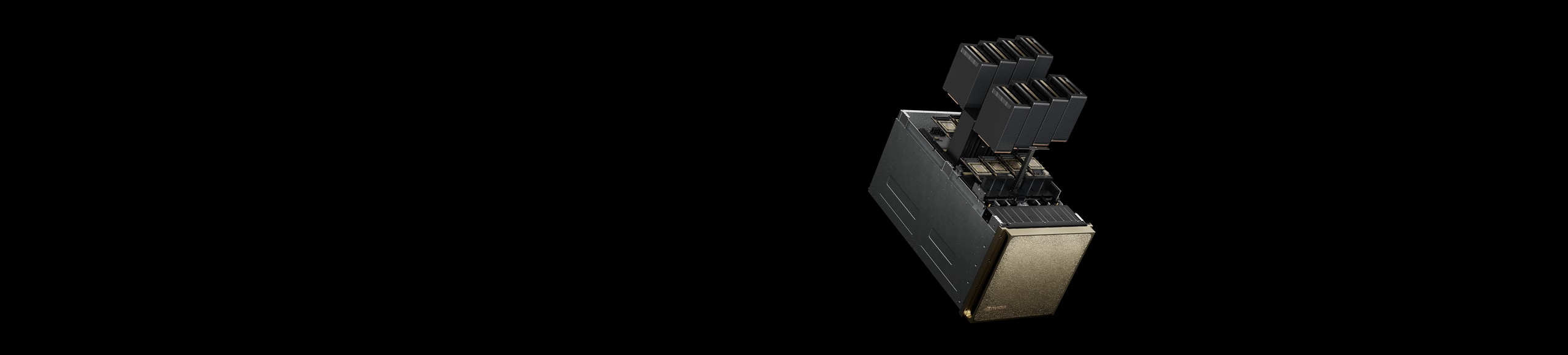

NVIDIA DGX B200

AI ファクトリーの基盤。

進化するイノベーションに支えられた革命的なパフォーマンス

NVIDIA DGX™ B200 は、AI 導入のあらゆる段階にある企業に規模を問わず対応する、開発から展開までのパイプラインを構築する統合型 AI プラットフォームです。第 5 世代 NVIDIA® NVLink™ で相互接続された 8 個の NVIDIA Blackwell GPU を搭載する NVIDIA DGX B200 は、前世代のシステムと比較して 3 倍のトレーニング パフォーマンス、15 倍の推論パフォーマンスを実現します。NVIDIA Blackwell アーキテクチャを採用し、DGX B200 は大規模言語モデル、レコメンダー システム、チャットボットなど、多様なワークロードに対応できるため、AI による変革を加速したい企業に最適です。

利点

統合された AI ファクトリー

パフォーマンス

NVIDIA DGX B200 搭載による次世代のパフォーマンス

リアルタイムの大規模言語モデル推論

予想パフォーマンスは変更される場合があります。トークン間レイテンシ (TTL) = 50 ミリ秒リアルタイム、ファースト トークン レイテンシ (FTL) = 5 秒、入力シーケンス長 = 32,768、出力シーケンス長 = 1,028、8 倍の 8 ウェイ NVIDIA DGX H100 GPU 空冷式と 1 倍の 8 ウェイ NVIDIA DGX B200 空冷式 (GPU あたりのパフォーマンス比較)。

AI トレーニングのパフォーマンスを強化

予想パフォーマンスは変更される場合があります。32,768 GPU スケール、4,096 x 8 ウェイ NVIDIA DGX H100 空冷クラスター:400G IB ネットワーク、4,096 x 8 ウェイ NVIDIA DGX B200 空冷クラスター: 400G IB ネットワーク。

仕様

NVIDIA DGX B200 仕様詳細

| GPU | 8 基の NVIDIA Blackwell GPU |

| GPUメモリ | 合計 1,440 GB、64 TB/秒の HBM3e 帯域幅 |

| パフォーマンス | FP4 Tensor コア: 144 PFLOPS | 72 PFLOPS* FP8 Tensor コア: 72 PFLOPS** |

| NVIDIA NVSwitch | 2 基 |

| NVIDIA NVLink 帯域幅 | 14.4 TB/秒の総帯域幅 |

| 消費電力 | 最大 14.3kW |

| CPU | 2 個の Intel® Xeon® Platinum 8570 プロセッサ 合計 112 コア、2.1 GHz (ベース)、 4 GHz (最大ブースト) |

| システム メモリ | 2 TB、4 TBまで拡張可能 |

| ネットワーキング | 4 基の OSFP ポートで 8 基のシングルポートを提供する NVIDIA ConnectX-7 VPI

|

| 管理ネットワーク | 10 Gb/秒のオンボード NIC (RJ45 搭載) 100 Gb/秒のデュアルポート イーサネット NIC ホスト BMC (ベースボード管理コントローラー、RJ45 搭載) |

| ストレージ | OS: 2 個の 1.9TB NVMe M.2 内部ストレージ: 8 個の 3.84TB NVMe U.2 |

| ソフトウェア | NVIDIA AI Enterprise – 最適化された AI ソフトウェア NVIDIA Mission Control - NVIDIA Run:ai テクノロジを活用した AI データ センターの運用と調整 NVIDIA DGX OS / Ubuntu – オペレーティング システム |

| ラック ユニット (RU) | 10 RU |

| システム サイズ | 高さ: 17.5in (444mm) 幅: 19.0in (482.2mm) 長さ: 35.3in (897.1mm) |

| 運用温度 | 10-35°C (50-90°F) |

| エンタープライズ サポート | 3 年間のビジネス標準ハードウェアおよびソフトウェア サポート |

|

*仕様は疎 | 密で表示されます。 |

|

関連情報

あらゆる企業に AI ファクトリーを提供

NVIDIA DGX SuperPOD

NVIDIA DGX SuperPOD™ は、あらゆるユーザーとワークロードに妥協のないパフォーマンスを提供するターンキー AI データセンター インフラ ソリューションです。あらゆる NVIDIA DGX システムで構成可能な DGX SuperPOD は、業界実証済みの結果を持つ、最も要求の厳しい AI トレーニングと推論ワークロードのためのスケーラブルなパフォーマンスを備えたリーダーシップクラスの高速インフラストラクチャを提供し、妥協のないパフォーマンスを実現します。

NVIDIA Mission Control の紹介

NVIDIA Mission Control は、世界クラスの専門知識をソフトウェアとして提供し、ワークロードからインフラストラクチャまで、AI ファクトリーの運用を効率化します。 NVIDIA Blackwell データ センターを強化し、推論とトレーニングの即時の俊敏性を実現し、インフラストラクチャの回復力にフルスタックのインテリジェンスを提供します。 あらゆる企業がハイパースケールの効率性で AI を運用でき、AI 実験を簡素化し加速することができます。

NVIDIA DGX プラットフォームの価値を最大化

NVIDIA エンタープライズ サービスは、NVIDIA DGX インフラ向けにサポート、教育、プロフェッショナル サービスを提供します。AI 導入のあらゆる段階を支援できる NVIDIA エキスパートにより、エンタープライズ サービスはお客様のプロジェクトを迅速かつ確実に立ち上げ、実行するお手伝いをします。

NVIDIA DGX のお客様限定トレーニング特典を受け取る

NVIDIA Deep Learning Institute (DLI) の AI エキスパートが、NVIDIA DGX のお客様限定で特別に提供するこの技術トレーニングでは、AI で最先端のブレークスルーをより速く達成する方法を学びます。

今すぐ始める