NVIDIA EGX™ 平台內含的最佳化軟體能在基礎架構中提供加速運算。透過 NVIDIA AI Enterprise,企業可以使用人工智慧與資料分析軟體的端對端雲端原生套件,該軟體經由 NVIDIA 最佳化、認證和支援,可在使用 NVIDIA 認證系統™ 的 VMware vSphere 上執行;NVIDIA AI Enterprise 內含 NVIDIA 的關鍵致能技術,能在現代混合雲端中快速部署、管理及調整人工智慧工作負載。

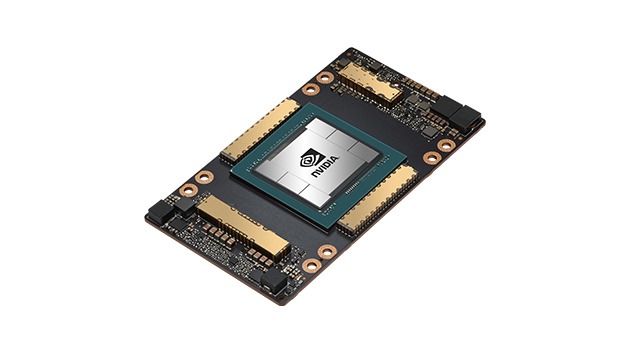

NVIDIA A100 Tensor 核心 GPU

為各種規模的作業提供前所未有的加速能力