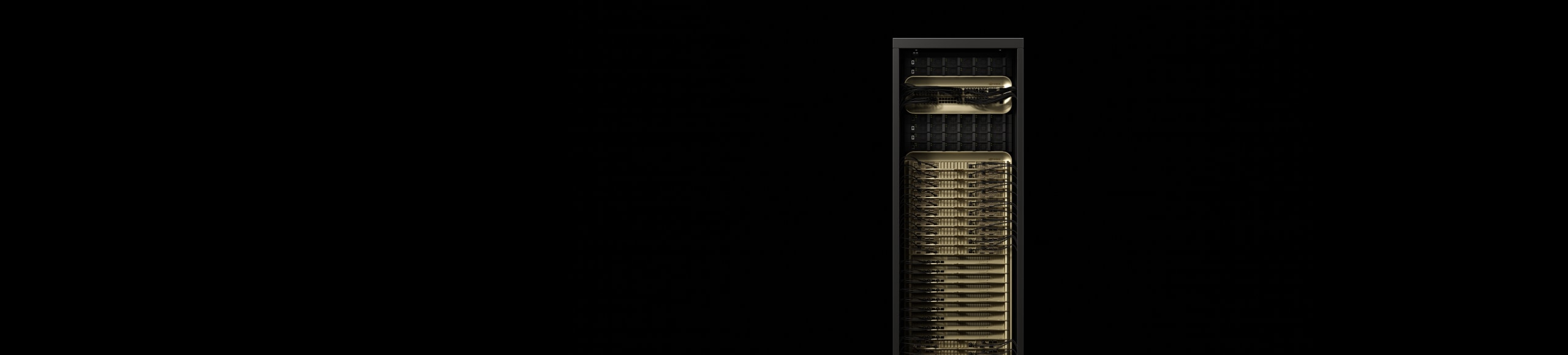

NVIDIA GB200 NVL72

生成 AI の新時代にパワーを与えます。

リアルタイムの兆単位パラメータ モデルを解放する

72 基の GPU を搭載した NVIDIA NVLink™ ドメインで、単一の巨大な GPU として機能します。これにより、リアルタイムで兆単位のパラメーターを有する大規模言語モデル (LLM) 推論が 30 倍高速化され、Mixture of Experts (MoE) アーキテクチャでは 10 倍の性能向上を提供します。

GB200 Grace Blackwell Superchip は、NVIDIA GB200 NVL72 の主要コンポーネントであり、2 つの高性能 NVIDIA Blackwell Tensor コア GPU と NVIDIA Grace™ CPU を、NVLink-C2C 相互接続を使用して 2 つの Blackwell GPU を接続しています。

ハイライト

次世代 AI とアクセラレーテッド コンピューティングをスーパーチャージ

LLM 推論とエネルギー効率: TTL = 50ミリ秒 (ms)、FTL = 5s、32,768 入力/1,024 出力、NVIDIA HGX™ H100 を InfiniBand (IB) でスケールし、GB200 NVL72 とトレーニング 1.8T MOE 4096x HGX H100 でスケール IB vs. 456x GB200 NVL72 でスケール IB。クラスター サイズ: 32,768

TPC-H Q4 クエリから派生した Snappy/Deflate 圧縮によるデータベースの結合と集約のワークロード。x86、H100 シングル GPU、および GB200 NLV72 vs. Intel Xeon 8480+ のシングル GPU のカスタム クエリ実装

予想されるパフォーマンスは変更される可能性があります。

NVIDIA GB200 NVL4

NVIDIA GB200 NVL4 は、コンバージド HPC と AI の未来を切り開き、NVLink-C2C インターコネクトを介して 4 台の NVIDIA NVLink Blackwell GPU と 2 台の Grace CPU を統合し、画期的なパフォーマンスを実現します。液冷 NVIDIA MGX™ モジュラー サーバーと互換性があり、前世代と比較して科学コンピューティング、科学トレーニング向け AI、推論アプリケーション向けに最大 2 倍のパフォーマンスを発揮します。

特徴

技術的なブレイクスルー

新たな産業革命のための AI ファクトリー

仕様

GB200 NVL72 の仕様¹

| GB200 NVL72 | GB200 Grace Blackwell Superchip | |

| 構成 | 36 Grace CPU | 72 Blackwell GPU | 1 Grace CPU | 2 Blackwell GPU |

| FP4 Tensor Core2 | 1,440 | 720 PFLOPS | 40 | 20 PFLOPS |

| FP8/FP6 Tensor Core2 | 720 PFLOPS | 20 TFLOPS |

| INT8 Tensor Core2 | 720 POPS | 20 POPS |

| FP16/BF16 Tensor コア2 | 360 PFLOPS | 10 TFLOPS |

| TF32 Tensor コア2 | 180 PFLOPS | 5 PFLOPS |

| FP32 | 5,760 TFLOPS | 160 TFLOPS |

| FP64 / FP64 Tensor コア | 2,880 TFLOPS | 80 TFLOPS |

| GPU メモリ帯域幅 | 13.4 TB HBM3E | 576 TB/秒 | 372 GB HBM3E | 16 TB/秒 |

| NVLink メモリ帯域幅 | 130 TB/秒 | 3.6 TB/秒 |

| CPU コア数 | 2592 個の Arm® Neoverse V2 コア | 72 個の Arm Neoverse V2 コア |

| CPU メモリ帯域幅 | 17 TB LPDDR5X | 14 TB/秒 | 最大 480GB LPDDR5X | 最高 512 GB/秒 |

|

1. スパース | 蜜度の仕様。 |

||

NVIDIA GB300 NVL72

NVIDIA GB300 NVL72 は、テストタイム スケーリング推論と AI 推論タスク向けに特別に構築された 72 基の NVIDIA Blackwell Ultra GPU と、36 基の Arm® ベースの NVIDIA Grace™ CPU を単一のプラットフォームに統合する完全液冷式ラックスケールのアーキテクチャを搭載しています。 GB300 NVL72 により高速化された AI ファクトリーは、NVIDIA Quantum-X800 InfiniBand または Spectrum-X Ethernet、ConnectX-8 SuperNIC、NVIDIA Mission Control Management を活用し、NVIDIA Hopper ベースのプラットフォームと比較して、AI ファクトリーの出力パフォーマンスが全体的に最大 50 倍向上します。