Dal riconoscimento vocale al training di assistenti virtuali personali, dal rilevamento di corsie stradali alle auto a guida autonoma, gli scienziati stanno affrontando sfide sempre più complesse nell'ambito dell'intelligenza artificiale. Risolvere problematiche di questo tipo richiede il training di modelli di deep learning estremamente complessi in tempi ragionevoli.

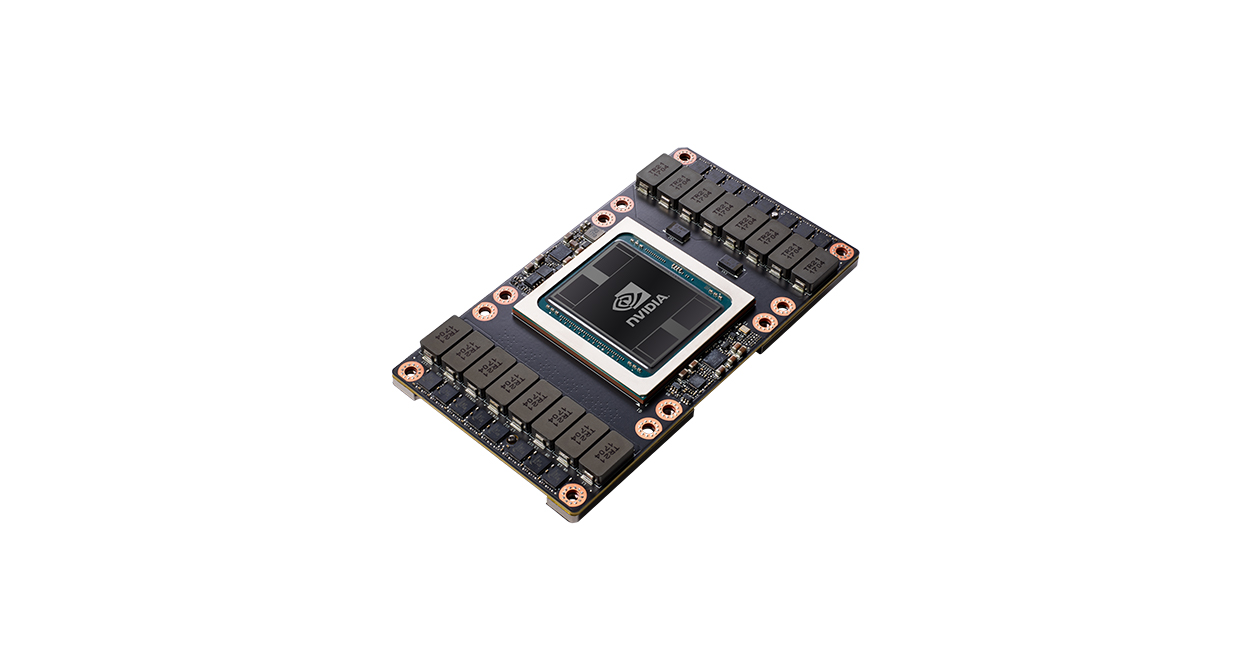

con 43 mila core Tensor, Tesla V100 è la prima GPU al mondo a superare il record di 100 teraops (TOPS) di prestazioni in deep learning. Il sistema NVIDIA NVLink™ di seconda generazione collega più GPU V100 a fino a 160 GB/s per creare i server di elaborazione più potenti del mondo. I modelli AI che richiederebbero settimane di risorse di elaborazione sui sistemi precedenti possono ora essere addestrati in pochi giorni. Con questa riduzione sostanziale dei tempi di training, tutta una serie di problemi sarà ora risolvibile grazie all'intelligenza artificiale.