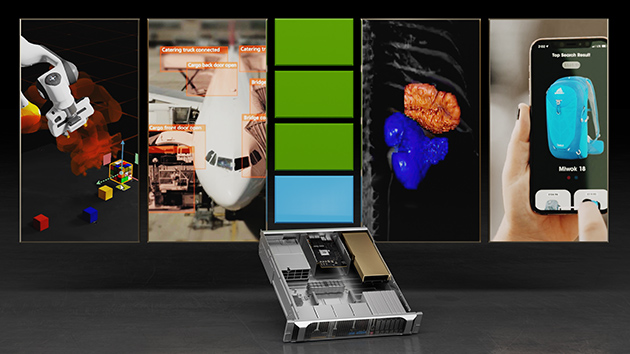

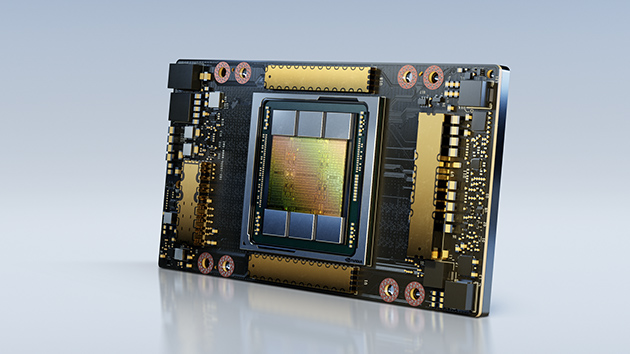

L'inferenza con IA viene implementata per migliorare la vita dei consumatori con esperienze intelligenti e in tempo reale e per ottenere informazioni da trilioni di sensori e telecamere sugli end-point. Rispetto ai server basati su sola CPU, i server Edge ed entry-level con GPU NVIDIA A2 Tensor Core offrono prestazioni di inferenza fino a 20 volte superiori, rendendo subito qualsiasi server in grado di gestire l'IA moderna.

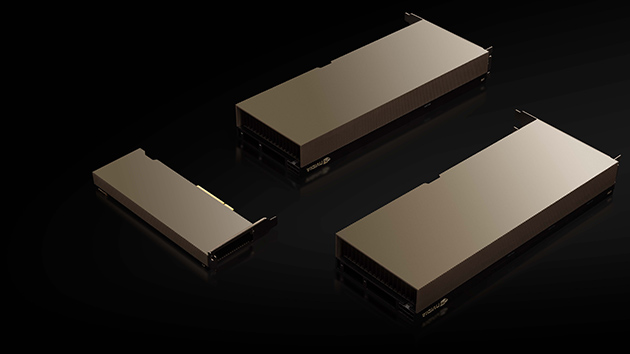

GPU NVIDIA A2 Tensor Core

GPU entry-level che porta NVIDIA AI su qualsiasi server.