La piattaforma NVIDIA EGX™ include software ottimizzato che fornisce computing accelerato in tutta l'infrastruttura. NVIDIA AI Enterprise è una suite aziendale completa, cloud-native di software IA e analisi dei dati, ottimizzata, certificata e supportata da NVIDIA per l'esecuzione su VMware vSphere con NVIDIA-Certified Systems. NVIDIA AI Enterprise include tecnologie chiave fornite da NVIDIA per una rapida distribuzione, gestione e scalabilità dei carichi di lavoro IA nel moderno cloud ibrido.

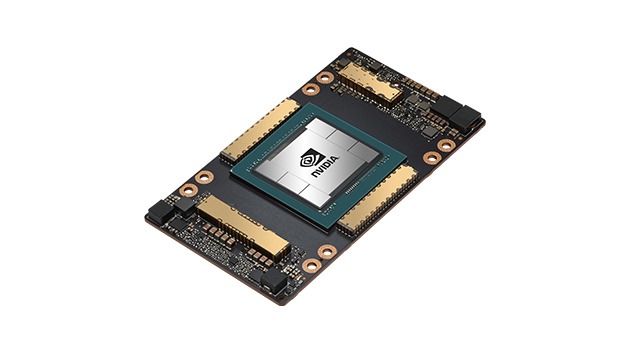

GPU NVIDIA A100 Tensor Core

Accelerazioni senza precedenti in ogni ordine di grandezza