La plataforma NVIDIA EGX™ incluye software optimizado que ofrece computación acelerada en toda la infraestructura. Con NVIDIA AI Enterprise, las empresas pueden acceder a un conjunto de software de análisis de datos e inteligencia artificial nativo del cloud de un extremo a otro que está optimizado, certificado y respaldado por NVIDIA para ejecutarse en VMware vSphere con los Sistemas Certificados por NVIDIA. NVIDIA AI Enterprise incluye tecnologías habilitadoras clave de NVIDIA para una rápida implementación, gestión y escalado de cargas de trabajo de IA en la cloud híbrida moderna.

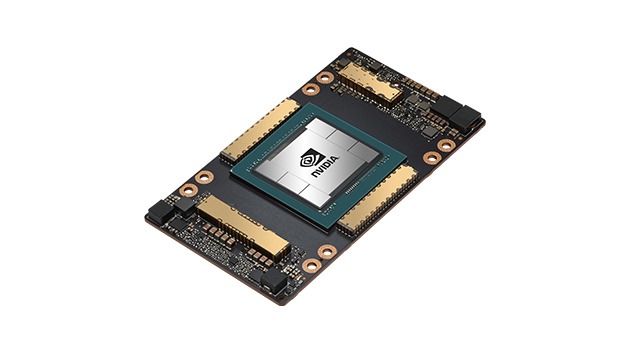

Gpu NVIDIA A100 Tensor Core

Aceleración sin precedentes en todas las escalas