A plataforma NVIDIA EGX™ inclui software otimizado que oferece computação acelerada em toda a infraestrutura. Com o NVIDIA AI Enterprise, as empresas podem acessar um conjunto de ponta a ponta, nativo do cloud de AI e software de análise de dados que é otimizado, certificado e suportado pela NVIDIA para rodar em VMware vSphere com os Sistemas Certificados pela NVIDIA. NVIDIA AI Enterprise inclui tecnologias essenciais da NVIDIA para rápida implantação, gerenciamento e escalonamento de cargas de trabalho de IA no cloud híbrido moderno.

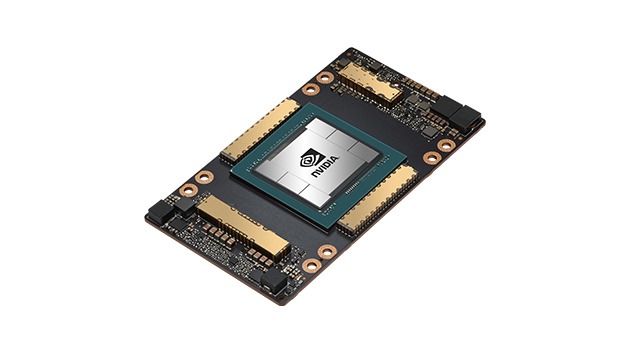

GPU NVIDIA A100 Tensor Core

Aceleração sem precedentes em todas as escalas