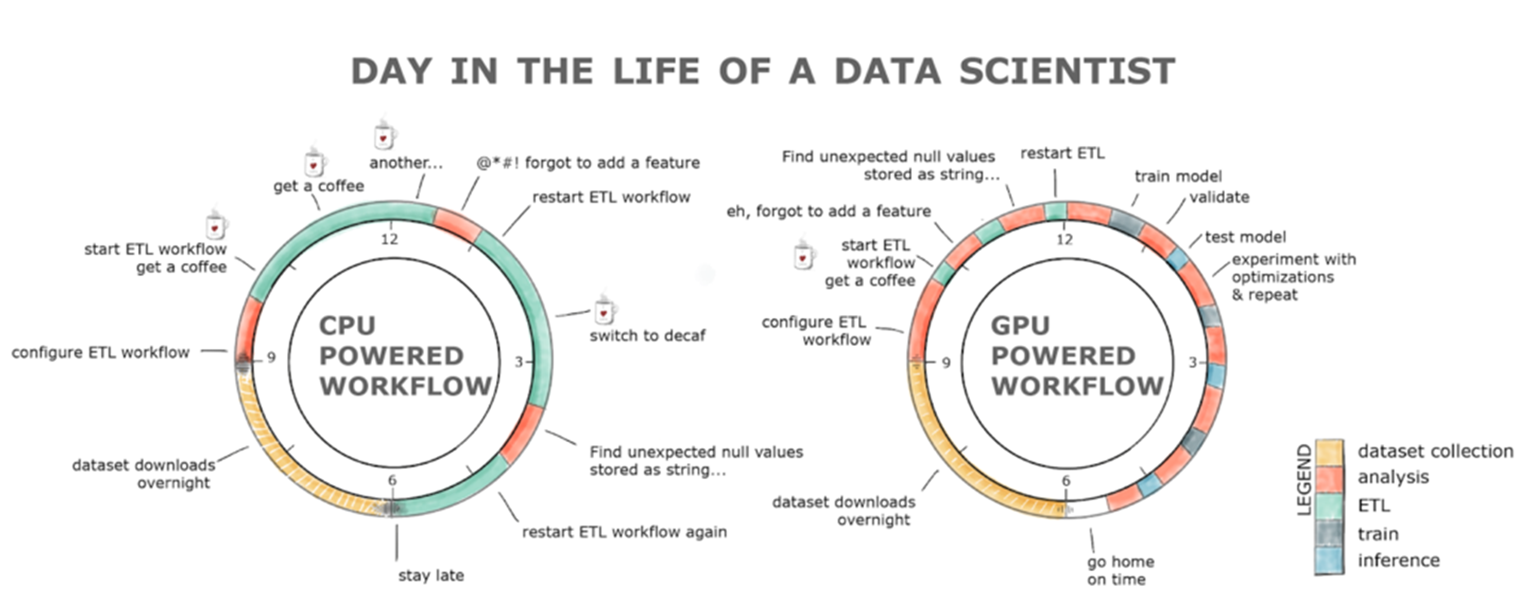

데이터 사이언스의 핵심적인 구성 요소는 데이터 탐색입니다. ML용 데이터 집합을 준비하려면 데이터 집합을 이해하고, 데이터 유형 및 형식을 정리 및 조작하고, 학습 알고리즘을 위한 특성을 추출해야 합니다. 이러한 작업은 ETL이라는 용어로 그룹화됩니다. ETL은 반복적이고 탐색적인 과정인 경우가 많습니다. 데이터 집합이 증가함에 따라, 이 프로세스의 상호 작용은 CPU에서 실행될 때 어려움을 겪습니다.

GPU는 지난 몇 년 동안 딥러닝(DL)의 발전을 책임져 온 반면, ETL 및 기존 ML 워크로드는 종종 Scikit-Learn과 같은 단일 스레드 도구 또는 Spark와 같은 대형 멀티 CPU 분산 솔루션을 통해 Python에서 계속하여 작성되어 왔습니다.

RAPIDS는 GPU에서 엔드 투 엔드 데이터 사이언스 및 분석 파이프라인을 완전히 실행하기 위한 오픈 소스 소프트웨어 라이브러리 및 API 제품군으로, 일반적인 엔드 투 엔드 데이터 과학 워크플로우에서 50배 이상의 속도 향상 요소를 달성합니다. RAPIDS는 데이터 로딩을 포함한 전체 데이터 사이언스 파이프라인을 가속화하여 더 생산성 높은 대화형 및 탐색 워크플로우를 지원합니다.

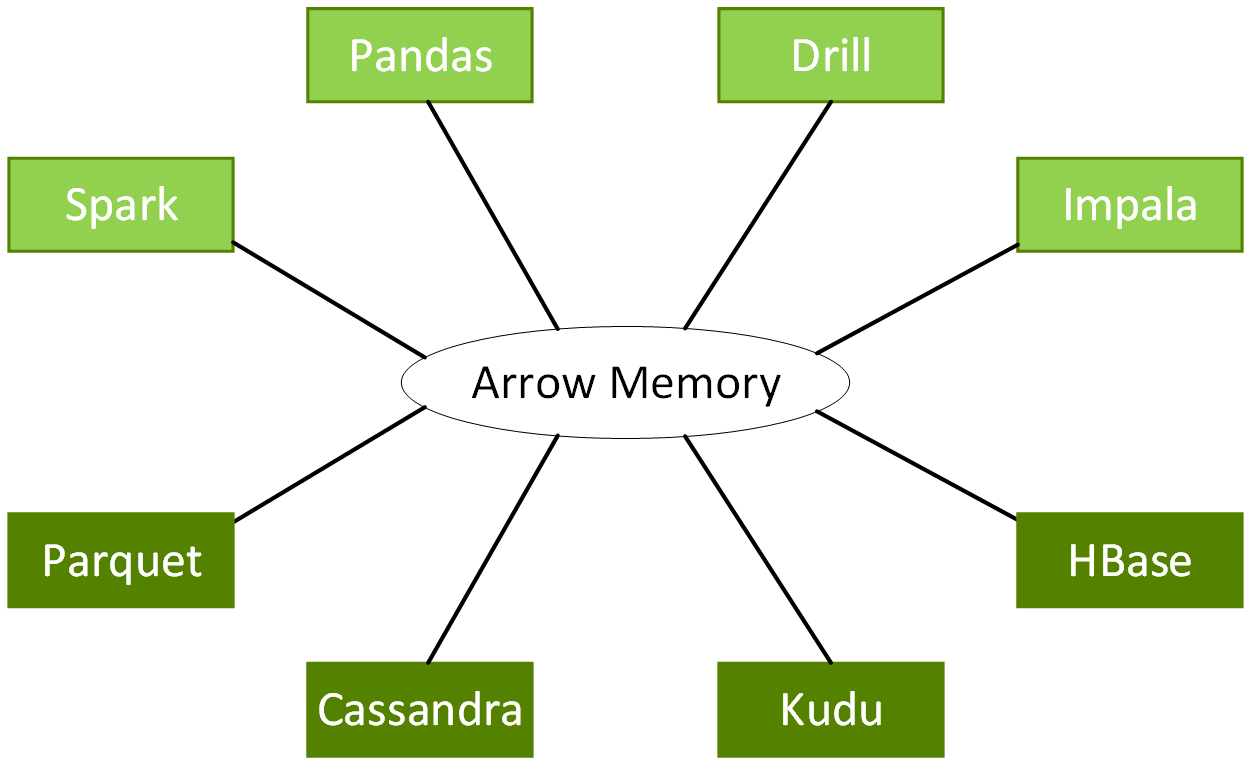

GPU 컴퓨팅을 위한 아키텍처 및 소프트웨어 플랫폼인 NVIDIA® CUDA®를 기반으로 구축된 RAPIDS는 사용자 친화적인 API를 통해 GPU 병렬 및 고대역폭 메모리 속도를 노출합니다. RAPIDS는 분석 및 데이터 과학을 위한 일반적인 데이터 준비 작업에 중점을 두고 있으며, 친숙한 DataFrame API를 통해 ApacheArrow 데이터 구조와 호환되는 강력한 GPU DataFrame을 제공합니다.

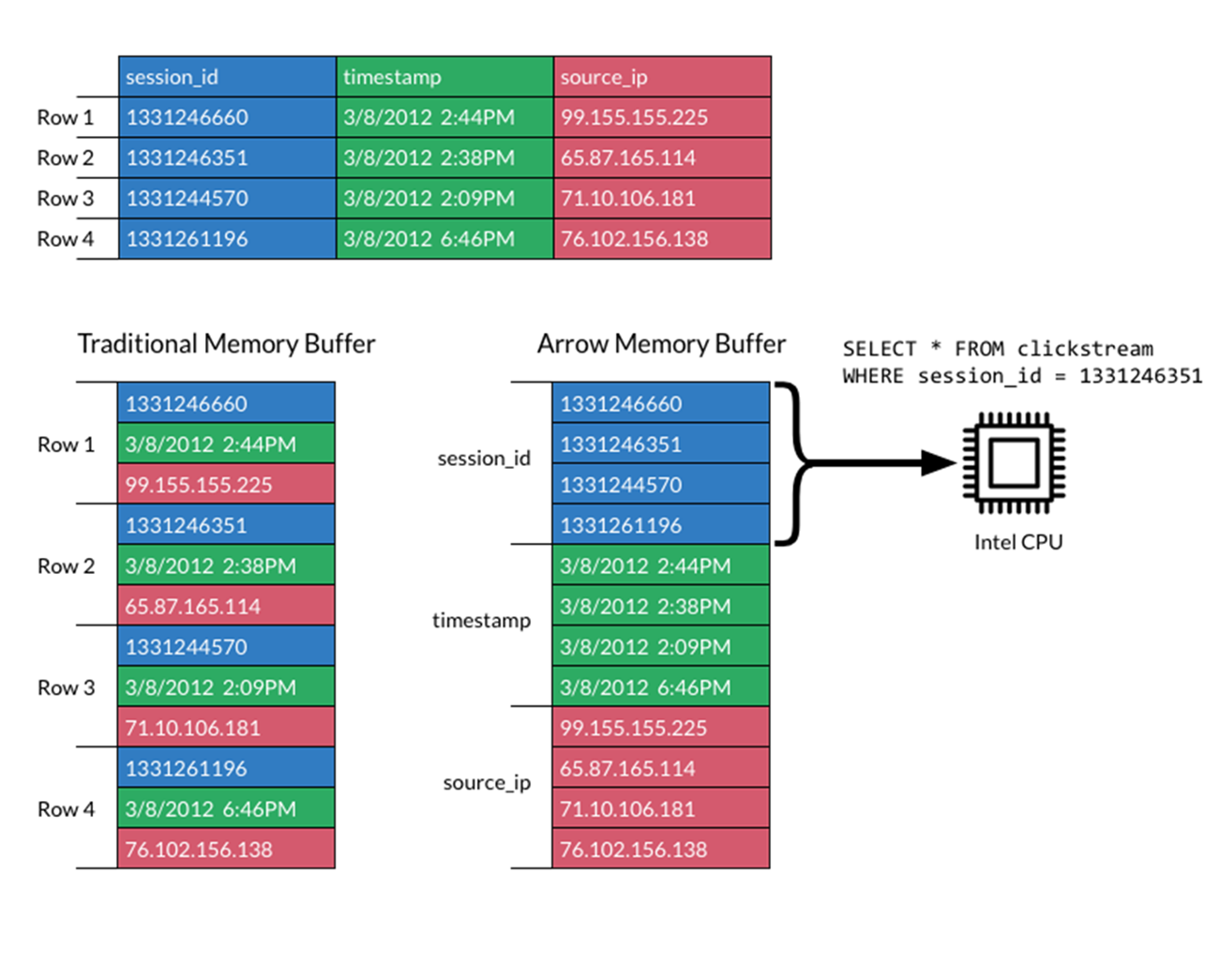

Apache Arrow는 데이터 지역성에 최적화된 표준화된 언어 독립 열 기반 메모리 형식을 지정하여 최신 CPU 또는 GPU에서 분석 처리 성능을 가속화하고 직렬화 오버헤드 없이 제로 카피 스트리밍 메시징 및 프로세스 간 통신을 제공합니다.

DataFrame API는 일반적인 직렬화 및 비직렬화 비용을 발생시키지 않고 다양한 ML 알고리즘과 통합하여 엔드 투 엔드 파이프라인 가속을 지원합니다.

RAPIDS는 낮은 수준의 CUDA 프로그래밍의 복잡성을 숨김으로써 데이터 사이언스 작업을 간단하게 실행하는 방법을 만듭니다. Python 및 높은 수준의 다른 언어를 사용하는 데이터 사이언티스트가 많아짐에 따라, 코드 변경이 최소 수준이거나 또는 아예 없는 수준의 실시간 가속화를 제공하는 것은 빠르게 발전하는 개발 과정에 필수적인 요소가 되었습니다.