Wir stellen NVIDIA Reflex vor: Eine Sammlung von Technologien zur Optimierung und Messung von Latenzzeiten in wettbewerbsoriteierten Spielen

Heute spielen 73 % der GeForce-Gamer kompetitive Multiplayer-Spiele oder E-Sports. Das meistgesehene E-Sports-Spiel, League of Legends, zog bei der Meisterschaft 2019 über 100 Millionen Zuschauer an – mehr als bei der letztjährigen NFL-Superbowl. Angesichts der Tatsache, dass E-Sports sowohl bei den Zuschauern als auch bei der Spielzeit mit traditionellen Sportarten konkurriert, ist es für die Spieler wichtiger denn je, dass ihr PC und ihre Grafikhardware so abgestimmt sind, dass sie ihr Bestes geben können. Aus diesem Grund hat NVIDIA vor einigen Jahren in ein E-Sports-Labor investiert, in dem sich NVIDIA-Spezialisten der Erforschung der Spieler- und Hardwareleistung widmen. Wir freuen uns, mit dir heute die ersten wichtigen Ergebnisse dieser Forschungen teilen zu können.

Neben unseren neuen GeForce RTX 30-Grafikprozessoren stellen wir NVIDIA Reflex vor, eine revolutionäre Suite von Grafikprozessor-, G-SYNC-Display- und Softwaretechnologien, die die Systemlatenz in kompetitiven Spielen misst und verringert (auch Click-to-Display-Latenz genannt). Die Reduzierung der Systemlatenz ist für kompetitive Gamer von entscheidender Bedeutung, da dann der PC und die Anzeige schneller auf Maus-und Tastatureingaben reagieren können, sodass der Spieler seine Gegner schneller wahrnehmen und Schüsse mit größerer Präzision abgeben kann.

NVIDIA Reflex beinhaltet zwei neue wichtige Technologien:

NVIDIA Reflex SDK: Eine neue Reihe von APIs, mit denen Spieleentwickler die Rendering-Latenz messen und reduzieren können. Durch die direkte Integration in das Spiel richtet der Reflex Low Latency-Modus die Spiele-Engine so aus, dass das Rendering just-in-time erfolgt, wodurch die Warteschlange für das GPU-Rendering wegfällt und der CPU-Rückstau reduziert wird. Dies führt zu Latenzreduzierungen, die über die üblichen reinen Treibertechniken hinausgehen, wie der NVIDIA Ultra Low Latency-Modus.

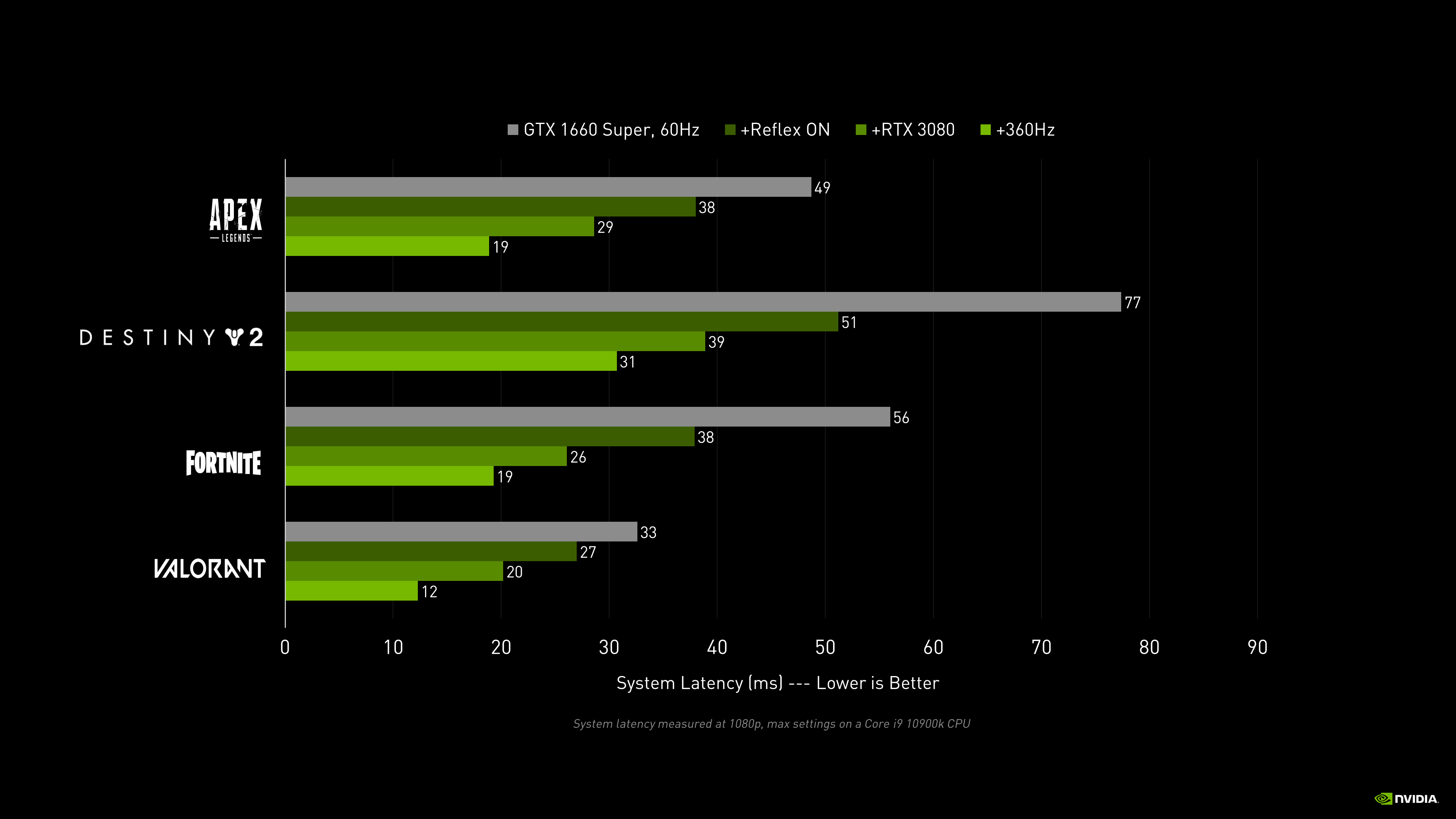

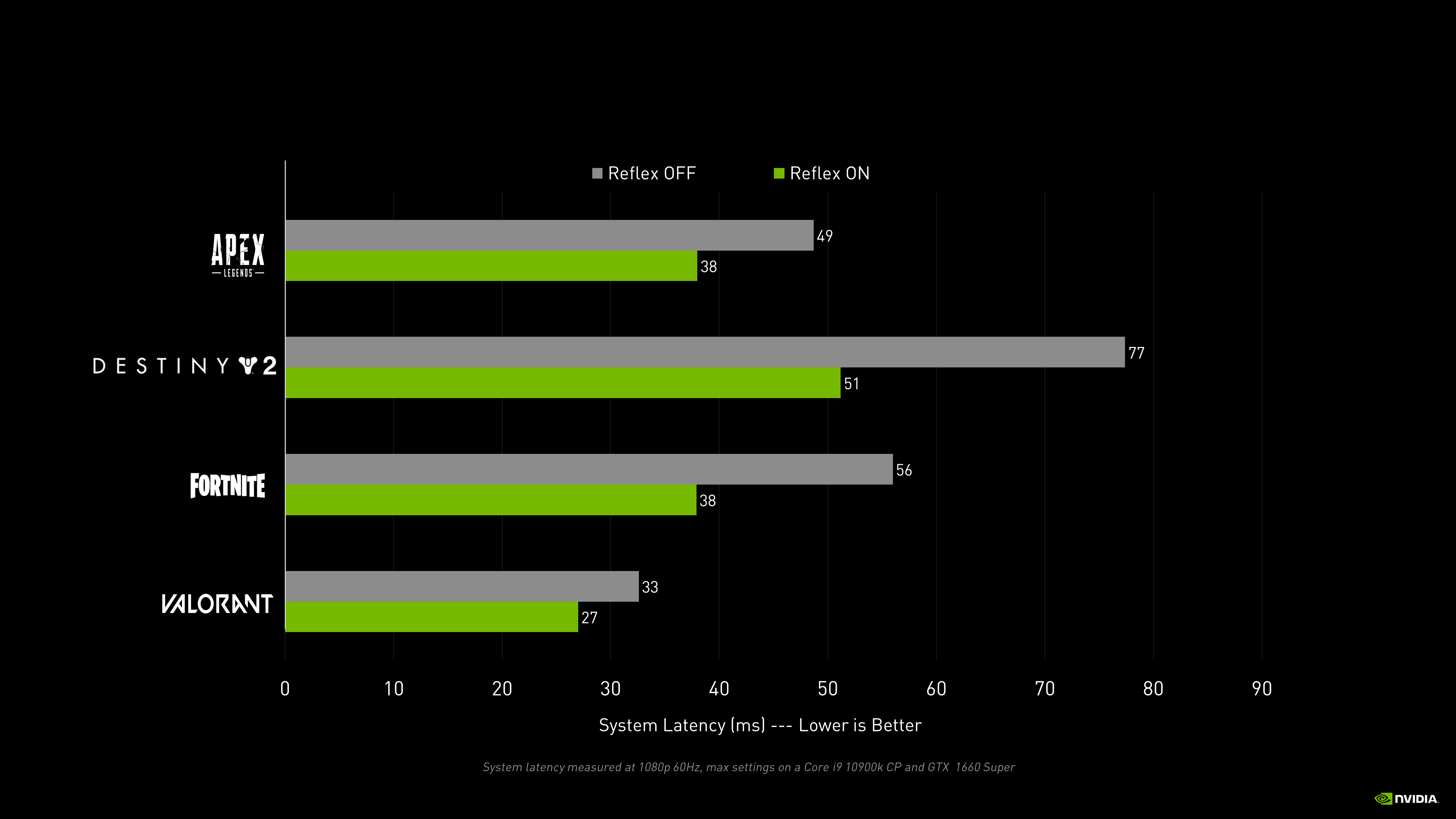

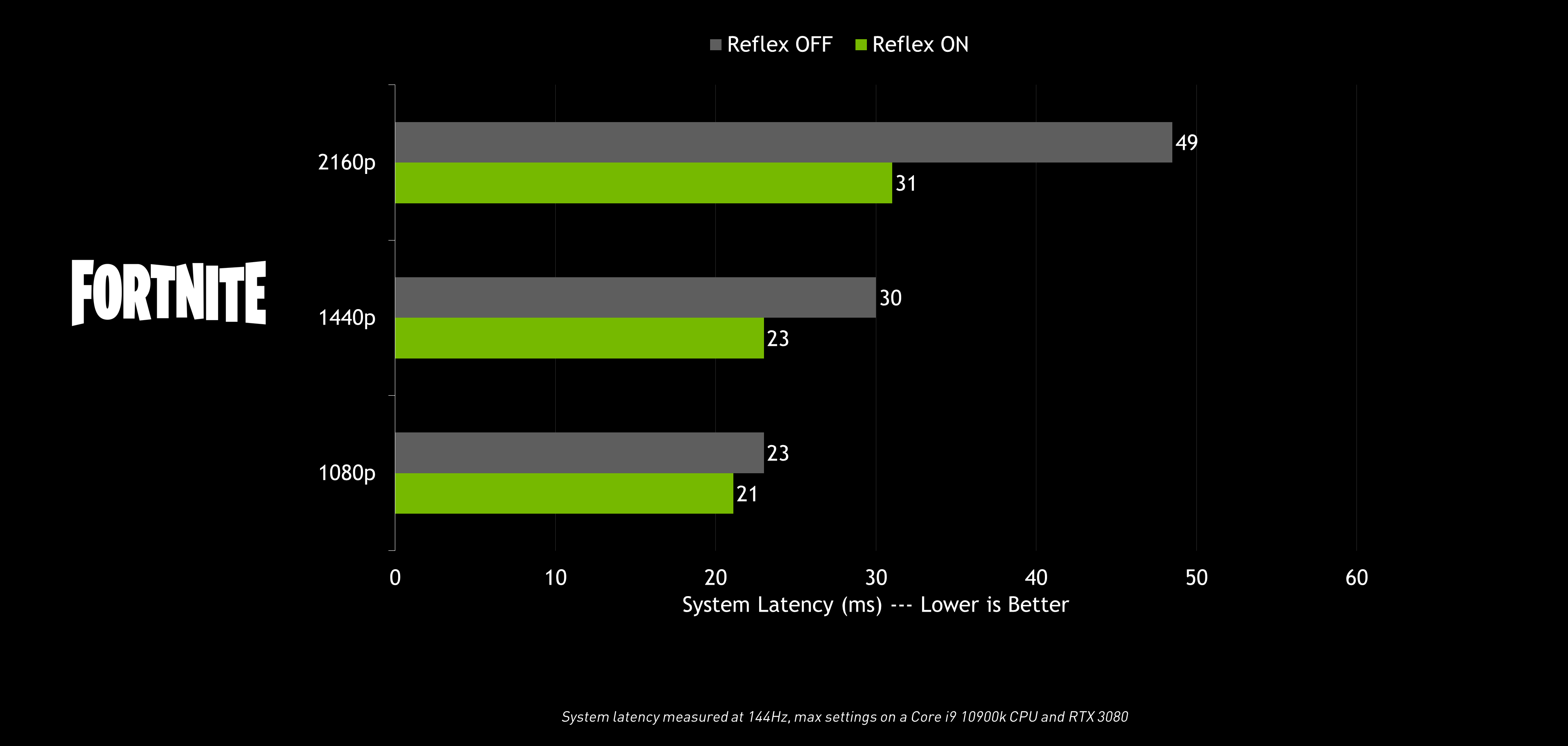

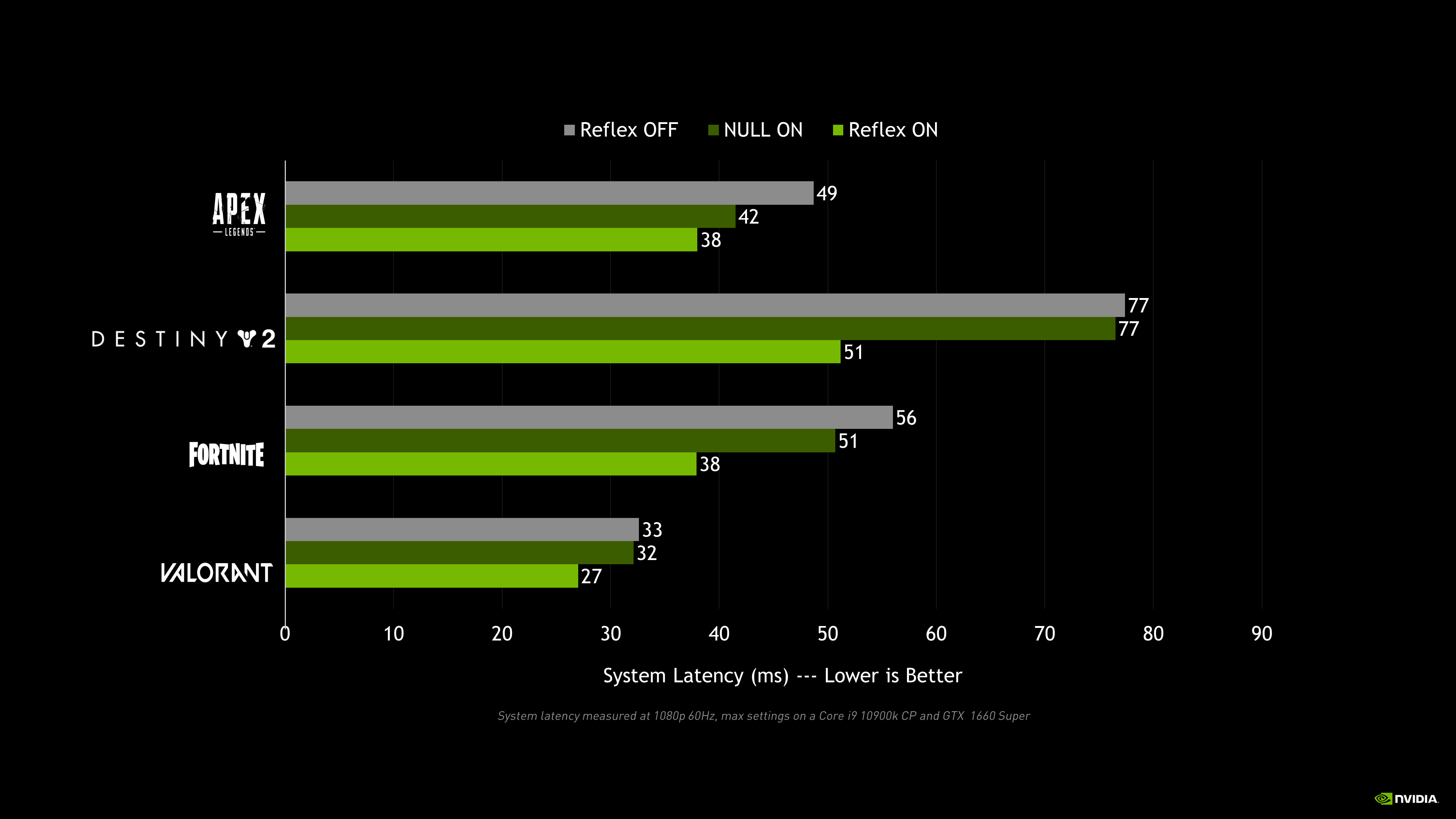

Der Reflex Low Latency-Modus kommt bald in den besten kompetitiven Spielen zum Einsatz, darunter Apex Legends, Call of Duty: Black Ops Cold War, Call of Duty: Modern Warfare – Warzone, Destiny 2, Fortnite und VALORANT, und wird zu Latenzverbesserungen bei GPU-intensiven Spielszenarien auf NVIDIA-Grafikkarten vom Typ GeForce GTX 900 und höher führen.

NVIDIA Reflex Latency Analyzer: Ein revolutionäres Tool zur Messung der Systemlatenz, das in neuen die G-Sync-E-Sports-Displays mit 360 Hz von Acer, Asus, MSI und Dell integriert ist und von den besten E-Sports-Peripheriegeräten von Asus, SteelSeries, Logitech und Razer unterstützt wird.

Der Reflex Latency Analyzer erkennt die Klicks, die von der Maus kommen, und misst dann die Zeit, die für die resultierenden Pixel (wie einen Gewehrmündungsblitz) erforderlich ist, um den Bildschirm zu aktualisieren. Diese Art der Messung war für Gamer bisher kaum möglich, da dafür spezielle Hochgeschwindigkeitskameras und -geräte erforderlich sind, die über 7000 $ kosten.

Während Gamer bislang die Reaktionsgeschwindigkeit ihres Systems aufgrund von Durchsatzwerten wie den Frames pro Sekunde (FPS) schätzen mussten, liefert der Reflex Latency Analyzer ein umfassenderes und genaueres Verständnis für die Maus-, PC-und Anzeigeleistungen. Mit dem Reflex Latency Analyzer können Gamer jetzt mit der Gewissheit in den Kampf ziehen, dass ihr System genau so funktioniert, wie es sollte.

In diesem Artikel werden wir einen tiefen Blick in die Systemlatenz und die NVIDIA Reflex-Technologie werfen – also schnall dich an!

- Was ist Latenz überhaupt?

- Ende-zu-Ende-Systemlatenz

- Was ist der Unterschied zwischen FPS und Systemlatenz?

- Warum ist die Systemlatenz so wichtig?

- Reduzieren der Systemlatenz mit NVIDIA Reflex

- Automatisches Tuning in GeForce Experience

- Messung der Systemlatenz mit NVIDIA Reflex

- Trainiere deine Zielgenauigkeit bei niedriger Latenz

- Zusammenfassung

Was ist Latenz überhaupt?

Die Latenz ist ein Zeitmaß, das die Verzögerung zwischen einer eingeleiteten Aktion und dem erwarteten Ergebnis beschreibt. Wenn wir etwas online oder im Lebensmittelgeschäft mit einer Kreditkarte bezahlen, ist die Verzögerung, die es dauert, bis unser Kauf bestätigt wird, die Latenz.

Gamer erleben in erster Linie zwei Arten von Latenz: Systemlatenz und Netzwerklatenz.

Netzwerklatenz ist die Roundtrip-Verzögerung zwischen dem Spiele-Client und dem Multiplayer-Server, besser auch als „Ping“ bekannt.

Diese Verzögerung kann unser Gameplay auf verschiedene Arten beeinflussen, je nachdem, wie der Netzwerkcode des Spiels die Netzwerklatenz verarbeitet. Hier kommen ein paar Beispiele:

- Verzögerte Trefferbestätigungen: Dein Schuss trifft, aber du erhältst erst viel später die Kill-Bestätigung. Dies kann zu Munitionsverschwendung oder Verzögerungen beim Anvisieren des nächsten Ziels führen.

- Verzögerte Interaktionen mit Objekten der Spielewelt wie dem Öffnen von Türen oder dem Plündern von Truhen.

- Verzögerte Positionierungen von Gegnern, was zum so genannten „Peekers Advantage“ führt (mehr dazu später).

Vergiss nicht, dass Netzwerklatenz nicht dasselbe ist wie Netzwerkinstabilitätsprobleme, wie z. B. Paketverluste und Paketfehler. Netzwerkinstabilität kann zu Problemen wie Rubberbanding und Desync führen. Als Rubberbanding bezeichnet man es, wenn du dich im Spiel bewegst und dann auf den Punkt zurückgesetzt wirst, an dem du ein paar Sekunden zuvor bereits warst. Wie ein Gummiband schnappst du elastisch in die Position zurück, an der der Server dich sieht. Als Desync bezeichnet man einen Paketverlust, der zu Stockungen im Netzwerk führt. Das sieht dann so aus, als würden die Feinde eine Sekunde lang innehalten und sich dann nach vorne in ihre korrekte Position teleportieren. Diese beiden häufigen Probleme sind keine Netzwerklatenzprobleme, sondern treten typischerweise dann auf, wenn ein Paket weiter transportiert werden muss und somit mit einer höheren Latenz korreliert ist.

Systemlatenz ist die Verzögerung zwischen Maus- oder Tastaturaktionen und den daraus resultierenden Pixel-Änderungen auf dem Display, wie dem Mündungsblitz einer Waffe oder einer Charakterbewegung. Dies wird auch als Click-to-Display- oder Ende-zu-Ende-Systemlatenz bezeichnet. Diese Latenz betrifft nicht den Gameserver, sondern nur die Peripheriegeräte, den Computer und das Display.

Diese Verzögerung wirkt sich auf mehrere Arten auf das Gameplay aus. Hier sind ein paar Beispiele:

- Verzögerte Reaktionszeiten: Du bewegst deine Maus, aber dein Ziel auf dem Bildschirm hinkt hinterher.

- Verzögerte Schüsse: Du schießt, aber das Einschussloch, die Geschossspur und der Waffenrückstoß hinken hinter dem tatsächlichen Mausklick her.

- Verzögerte Positionierungen von Gegnern, sogenannter „Peekers Advantage“. (Genau, der „Peekers Advantage“ wird ebenfalls durch die Systemlatenz beeinflusst!)

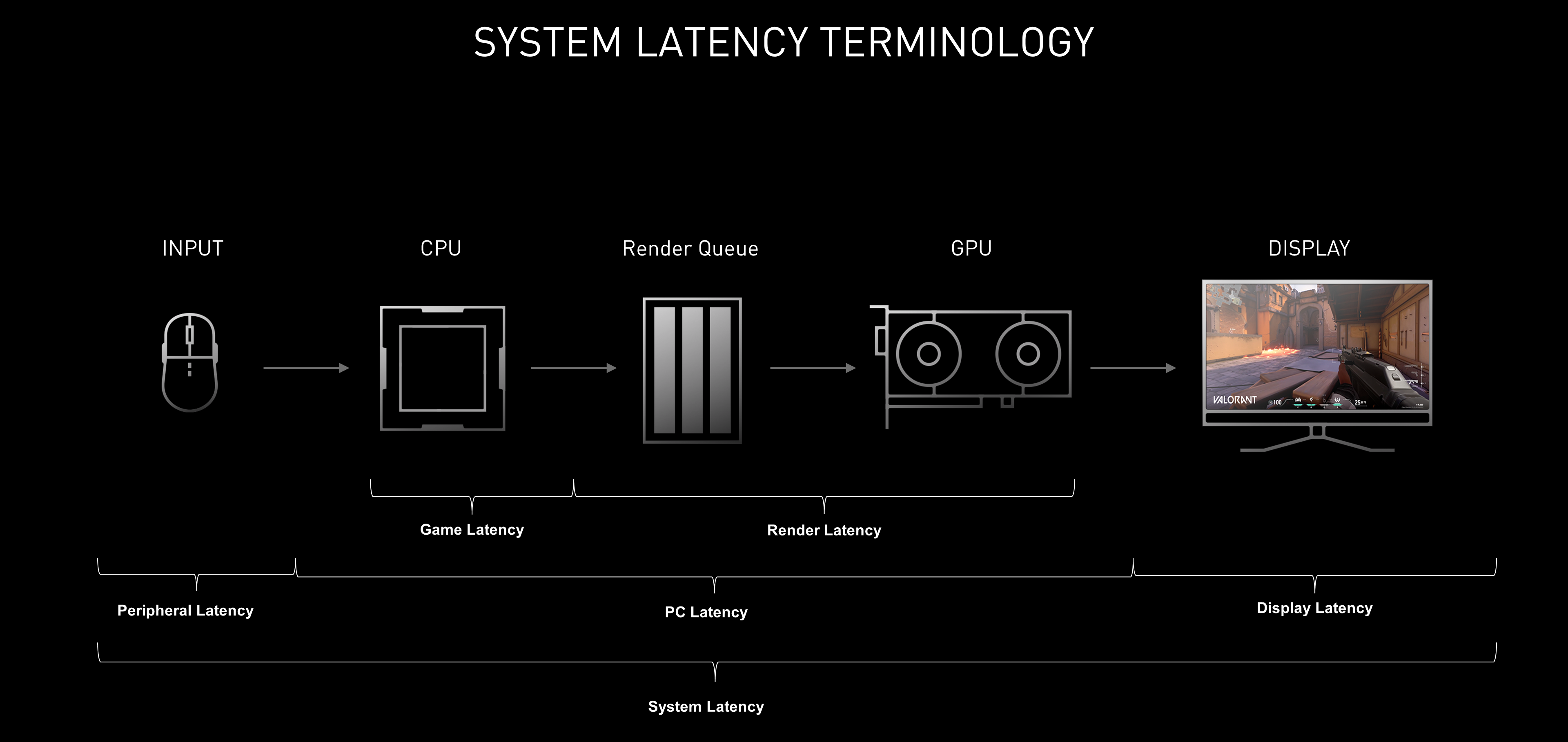

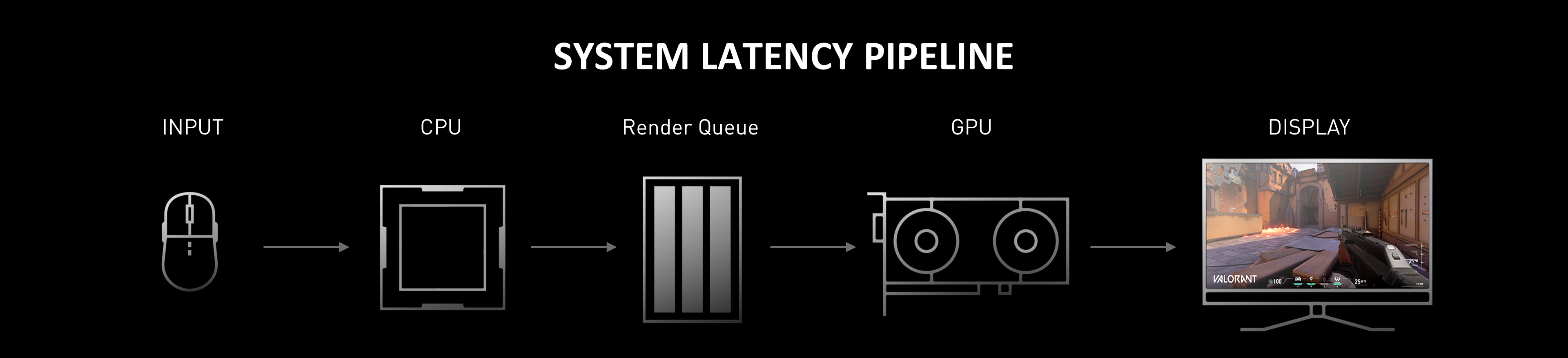

Auf der übergeordneten Ebene gibt es drei Hauptelemente für die Systemlatenz: die Peripheriegeräte (wie eine Maus), den Computer und den Bildschirm. Leider ist diese Latenz aufgrund der Verwendung der Begriffe „Eingangslatenz“ oder „Eingangsverzögerung“ zur Bezeichnung verschiedener Teile der Systemlatenz schwer zu beschreiben.

Beispielsweise wird der Begriff „Eingangslatenz“ auf der Verpackung einer Maus verwendet, wenn es darum geht, wie lange die Maus für die Verarbeitung deines Klicks benötigt. Du findest den Begriff auch auf der Verpackung eines Monitors, um anzugeben, wie lange die Anzeige zur Verarbeitung eines Frames benötigt. Außerdem wird der Begriff bei Spielen und Software-Tools verwendet, wenn es wirklich darum geht, wie lange das Spiel zur Verarbeitung der Eingaben benötigt. Wenn dies alles als „Eingangslatenz“ bezeichnet wird, was stimmt dann?

Ende-zu-Ende-Systemlatenz

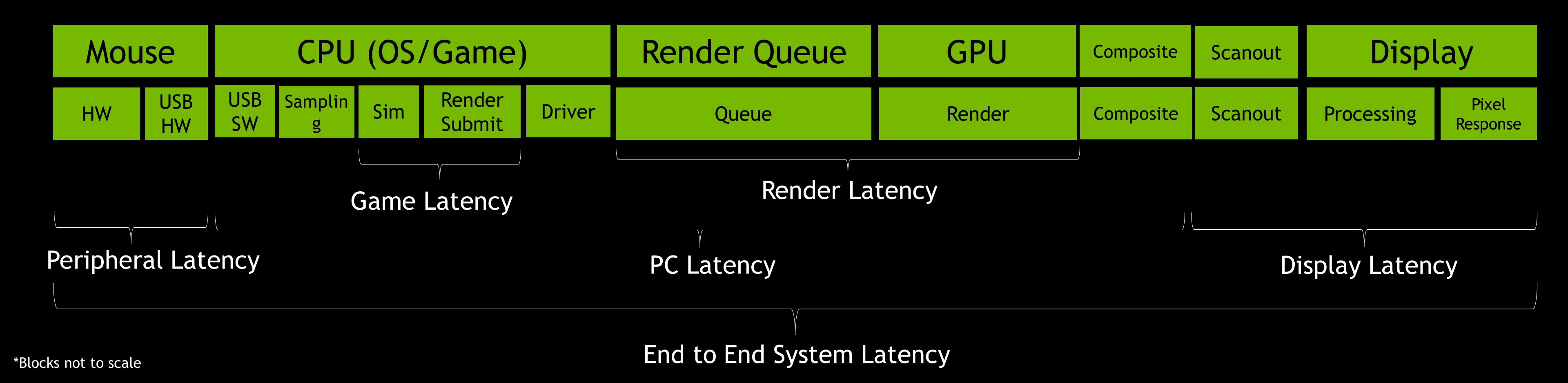

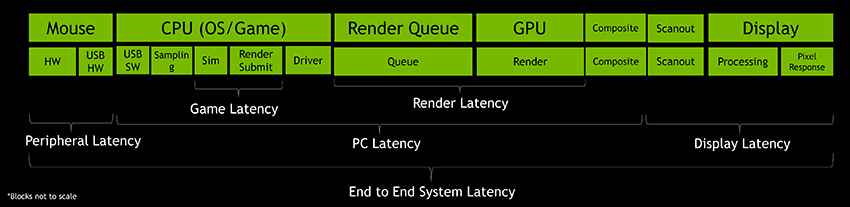

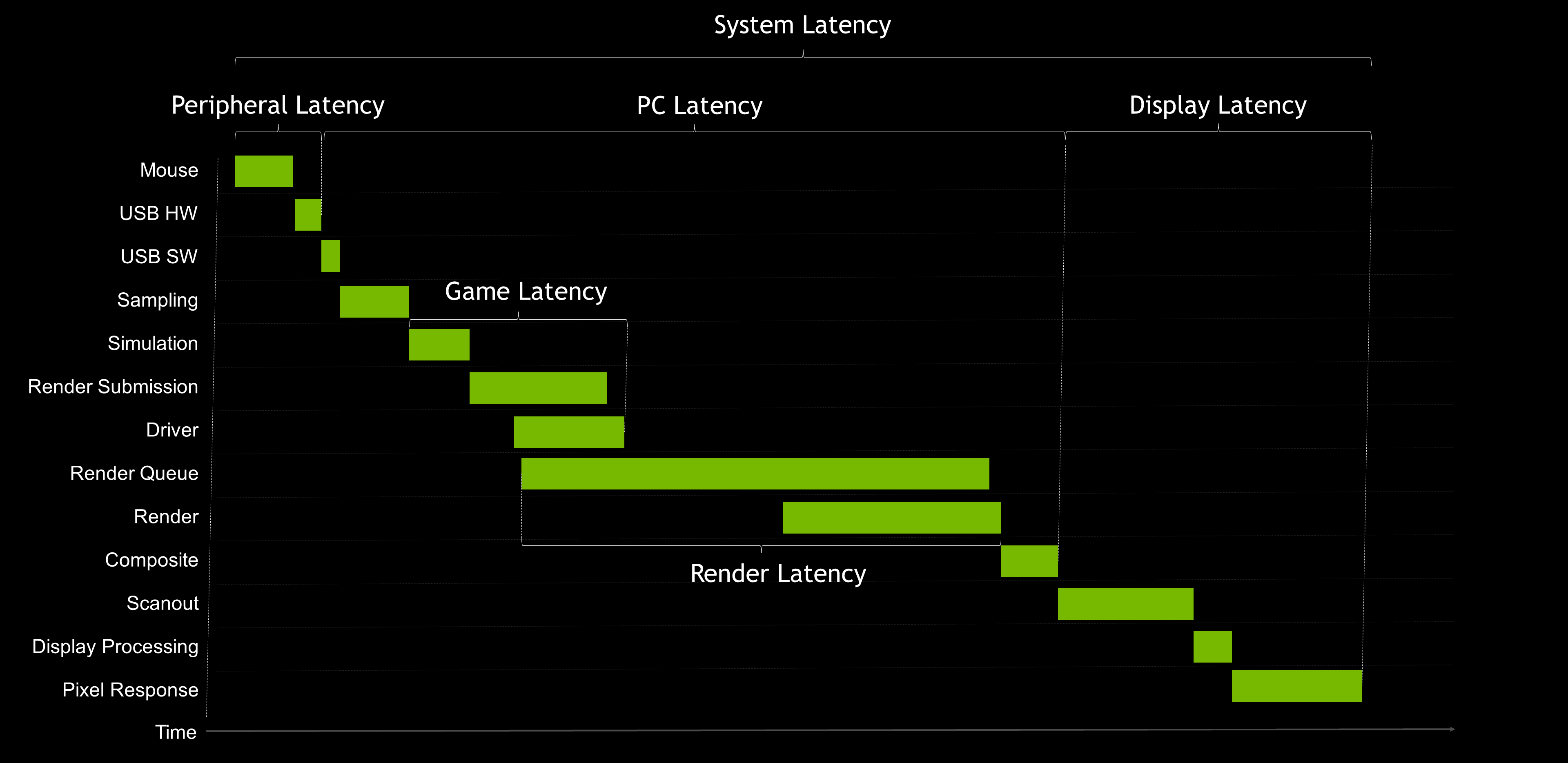

Nehmen wir uns einen Moment Zeit, um ein Level tiefer zu gehen und einige Begriffe festzulegen, die präziser als „Eingabeverzögerung“ sind:

- Peripherielatenz: Die Zeit, die dein Eingabegerät zum Verarbeiten der mechanischen Eingaben und zum Senden dieser Eingabeereignisse an den PC benötigt

- Spielelatenz: Die Zeit, die die CPU benötigt, um Eingaben oder Änderungen in der Spielewelt zu verarbeiten und einen neuen Frame an den Grafikprozessor zum Rendern zu senden

- Rendering-Latenz:Die Zeit zwischen dem Zeitpunkt, an dem der Frame in die zu rendernde Warteschlange gebracht wird, und dem Zeitpunkt, an dem die GPU den Frame vollständig gerendert hat

- PC-Latenz: Die Zeit, die ein Frame braucht, um durch den PC zu reisen. Dies umfasst sowohl die Spielelatenz als auch die Rendering-Latenz.

- Displaylatenz: Die Zeit, die das Display benötigt, um ein neues Bild darzustellen, nachdem der Grafikprozessor das Rendern des Frames abgeschlossen hat.

- Systemlatenz:Die Zeit, die die gesamte Ende-zu-Ende-Messung umfasst, vom Beginn der Peripherielatenz bis zum Ende der Displaylatenz

Dies sind Definitionen auf übergeordneter Ebene, die zwar einige Details vernachlässigen, uns aber dafür eine hervorragende Grundlage für eine effektive Kommunikation über den Begriff Latenz liefern. Wir werden später im Artikel näher auf die einzelnen Stufen eingehen. Wenn du also mehr technische Details möchtest, geh gleich weiter zum Abschnitt für Fortgeschrittene.

Was ist der Unterschied zwischen FPS und Systemlatenz?

Im Allgemeinen entspricht eine höhere FPS-Rate einer niedrigeren Systemlatenz, doch ist dies keinesfalls eine 1-zu-1-Beziehung. Um das besser zu verstehen, müssen wir einen Schritt zurücktreten und darüber nachdenken, wie wir unsere Interaktionen mit unserem PC messen. Da ist zunächst die Anzahl der Bilder, die uns unser Display pro Sekunde anzeigen kann. Diese Zahl ist eine Durchsatzrate, die als FPS (Frames pro Sekunde) bezeichnet wird. Der zweite Faktor ist die Zeit, die es braucht, bis sich unsere Aktionen in einem dieser Bilder widerspiegeln – das ist die Zeitspanne, die als Systemlatenz bezeichnet wird.

Wenn wir einen PC haben, der zwar 1000 FPS rendern kann, aber es trotzdem eine Sekunde dauert, bis unsere Eingaben auf das Display gelangen, wäre das ein schlechtes Erlebnis. Wenn unsere Aktionen jedoch augenblicklich sichtbar sind, aber unsere Framerate 5 FPS beträgt, so wäre das auch kein tolles Erlebnis.

Was ist also wichtiger? Vor mehr als einem Jahr haben wir uns daran gemacht, diese Frage zu beantworten, und die Ergebnisse sind recht interessant. Unsere komplette Untersuchung ist auf SIGGRAPH Asia zu finden, aber kurz gesagt haben wir festgestellt, dass die Systemlatenz die Fähigkeit von Probanden, Zielaufgaben in einem Zieltrainer zu erledigen, viel stärker beeinflusst als die Rate der auf ihrem Monitor angezeigten Frames. Aber warum ist das so?

Warum ist die Systemlatenz so wichtig?

Beginnen wir mit der Beantwortung dieser Frage, indem wir uns einige Beispiele aus realen Spielen ansehen:

Sehen wir uns zunächst die Hit Registration an. Hit Registration ist ein Begriff, den Gamer verwenden, wenn sie darüber sprechen, wie gut das Spiel ihre Schüsse auf einen anderen Spieler erkennt. Wir geben häufig der Hit Registration die Schuld, wenn wir WISSEN, dass unser Schuss getroffen hat. Das kennen wir alle. Aber was ist die Hit Registration wirklich?

Bei diesem Schuss wurde die Maustaste gedrückt, als sich das Fadenkreuz über dem Ziel befand, aber wir haben es trotzdem verfehlt. Aufgrund der Systemlatenz und der Bewegung des Gegners hat die Spiele-Engine gesehen, dass sich die Position des Fadenkreuzes tatsächlich hinter dem Ziel befindet. Tatsächlich liegt das, was auf dem Display zu sehen ist, hinter dem aktuellen Zustand der Spiele-Engine. Das liegt einfach daran, dass es eine Weile dauert, bis der PC die Informationen verarbeitet, den Rahmen gerendert und auf dem Bildschirm angezeigt hat. Bei Spielen, bei denen es auf Millisekunden ankommt, können 30 bis 40 ms zusätzliche Verzögerung bedeuten, dass man das Spiel nicht gewinnt.

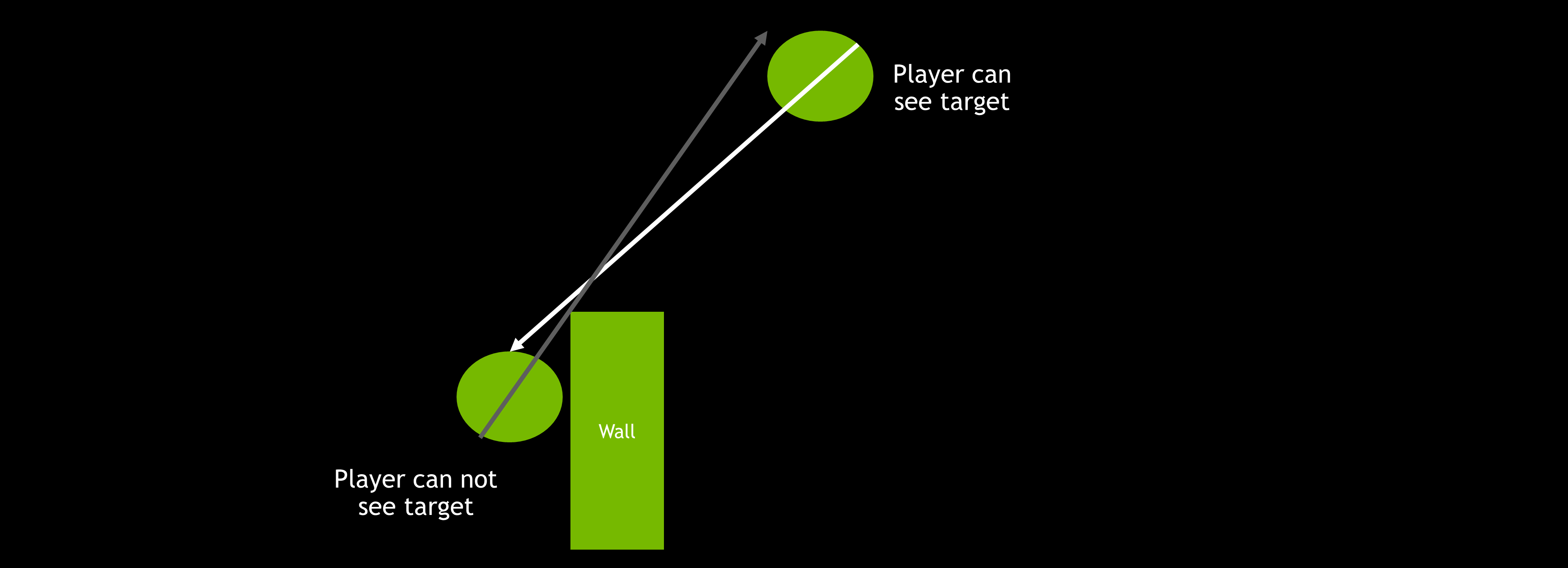

Als nächstes wollen wir uns den Peekers Advantage ansehen. Auf hohen Levels in kompetitiven Spielen hältst du normalerweise einen bestimmten Winkel, wenn du einen extremen Winkelvorteil hast (z. B. wenn du weiter von einer Ecke entfernt bist als dein Gegner), um ein Merkmal von Online-Spielen auszugleichen, das als Peekers Advantage bezeichnet wird.

Der Vorteil von Peeker ist der Bruchteil einer Sekunde, den der Angreifer erhält, wenn er bei einem Spieler, der einen Winkel einnimmt, um eine Ecke schaut. Da es eine gewisse Zeit dauert, bis die Positionsangaben des angreifenden Spielers über das Netzwerk zum Verteidiger gelangen, hat der angreifende Spieler einen inhärenten Vorteil. Um das auszugleichen, „tänzeln“ die Spieler an der Ecke. Sie schauen schnell um die Ecke und ducken sich in die Deckung zurück, da sie so einen Gegner sehen können, bevor sie gesehen werden, was ihnen Vorteile von Sekundenbruchteilen verschafft. Dieses Phänomen wird oft als ein Merkmal des Netzwerkcodes oder der Netzwerklatenz des Spiels angesehen. Die Systemlatenz kann jedoch eine große Rolle beim Peekers Advantage spielen.

Wie du in der obigen Aufnahme sehen kannst, waren beide Spieler gleich weit vom Winkel entfernt, und ihre Pings waren gleich. Der einzige Unterschied war Ihre Systemlatenz.

Ähnlich wie bei der Hit Registration wird bei höherer Systemlatenz deine Ansicht der Spielewelt verzögert, so dass das Ziel dich sehen kann, bevor du das Ziel siehst. Wenn die Latenzzeit deines Systems viel niedriger ist als die deines Gegners, kannst du den Peekers Advantage möglicherweise komplett vermeiden. Auch wenn die Auswirkungen des Networking hierbei ebenfalls eine Rolle spielen, trägt eine niedrigere Systemlatenz generell dazu bei, sowohl den Peekers Advantage bei der Verteidigung abzuschwächen als auch diesen beim Angriff zu nutzen.

Abschließend wollen wir uns mit der Zielgenauigkeit befassen, insbesondere bei Schnellschüssen. Schnellschüsse sind wohl das wichtigste Trainingselement bei kompetitiven Spielen wie CS:GO oder VALORANT. In Sekundenbruchteilen musst du dein Ziel erfassen, es anvisieren und mit unglaublicher Präzision abdrücken. Das erfordert eine Genauigkeit von wenigen Millisekunden. Aber hattest du jemals das Gefühl, dass deine Schnellschüsse nicht konsistent sind, egal, was du auch tust?

Zum Zielen gehört eine Reihe von Unterbewegungen – unterbewusste Korrekturen auf der Grundlage der aktuellen Position des Fadenkreuzes relativ zum Standort des Ziels. Bei höheren Latenzen ist diese Rückkopplungszeit höher, was zu einer niedrigeren Präzision führt. Darüber hinaus variiert die Latenz bei höheren Durchschnittslatenzen stärker, was bedeutet, dass es für deinen Spielercharakter schwieriger ist, Vorhersagen zu treffen und sich daran anzupassen. Das Endergebnis ist ziemlich klar: hohe Latenz bedeutet weniger Präzision.

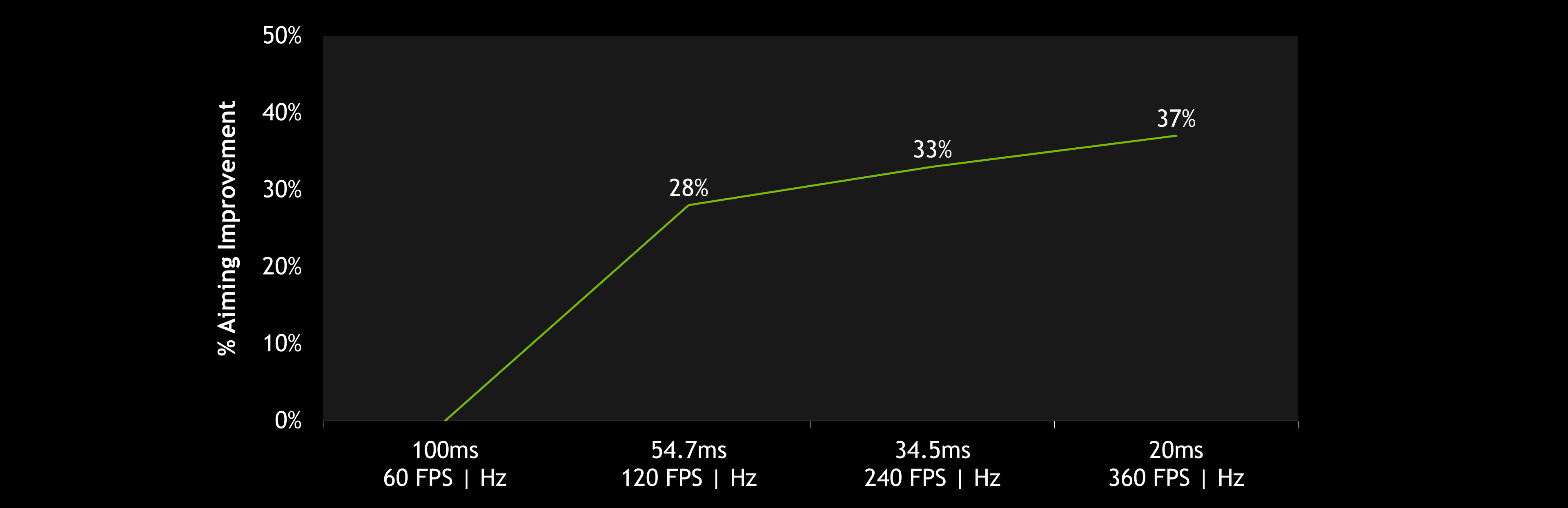

Und das führt uns zu den Ergebnissen unserer bereits erwähnten Studie. In der folgenden Tabelle kannst du sehen, wie stark sich die niedrigere Latenz bei der Messung der Schnellschussgenauigkeit auswirkte.

Bei kompetitiven Spielen verringern höhere FPS- und Aktualisierungsraten (Hz) deine Latenzzeit und geben deinen Eingaben mehr Möglichkeiten, auf dem Bildschirm zu landen. Selbst geringe Verringerungen der Latenz haben einen Einfluss auf die Umschaltleistung. In unserem aktuellen E-Sports Research Blog befasst sich das Team von NVIDIA Research damit, wie sich die Systemlatenz auf verschiedenen Ebenen auf die Leistung des Spielers auswirkt.

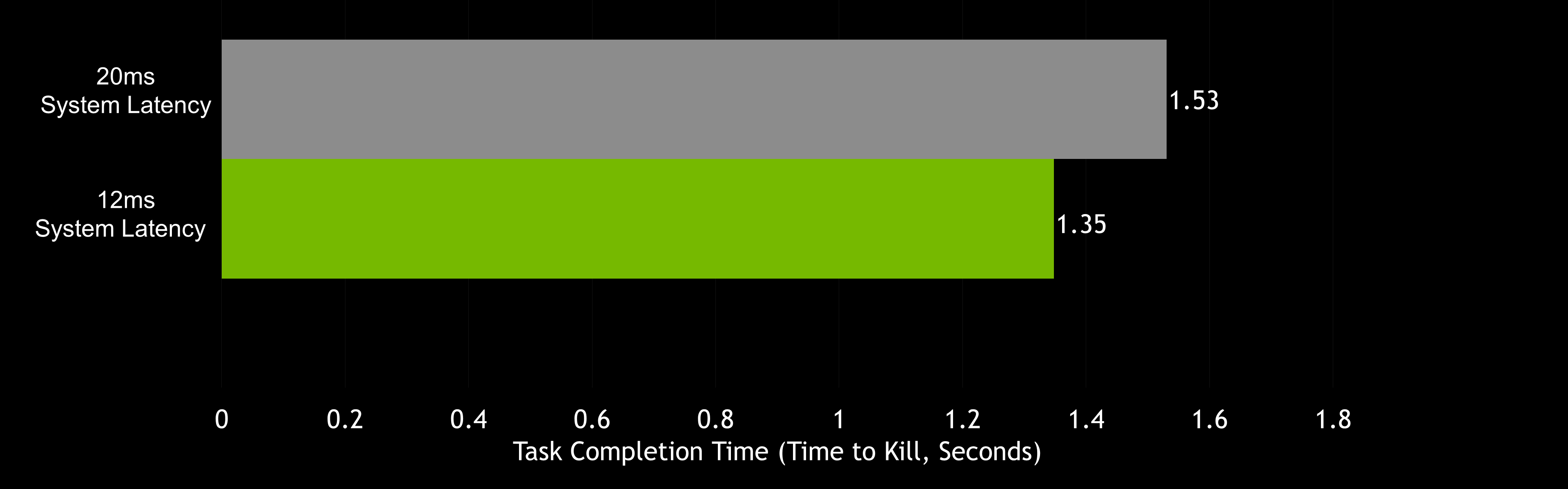

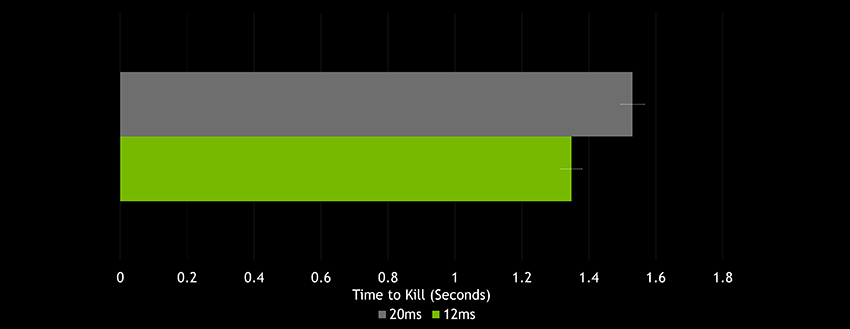

NVIDIA Research hat herausgefunden, dass selbst geringfügige Unterschiede bei der Systemlatenz (12 ms statt 20 ms) einen deutlichen Unterschied bei der Zielgenauigkeit ausmachen können. Tatsächlich betrug der gemessene durchschnittliche Unterschied bei der Erfüllung der Zielaufgabe (die Zeit, die benötigt wird, um ein Ziel zu erfassen und zu schießen) beim Vergleich eines 12 ms-PCs mit einem 20 ms-PC 182 ms – das ist etwa das 22-fache der Systemlatenzdifferenz. Bei einem 128 Tick-Server mit VALORANT oder CS:GO würde das bei gleicher Zielschwierigkeit bedeuten, dass deine Schüsse auf dem 12 ms-PC durchschnittlich 23 Ticks früher im Ziel landen. Doch die meisten Gamer spielen auf Systemen mit einer Systemlatenz von 50 bis 100 ms!

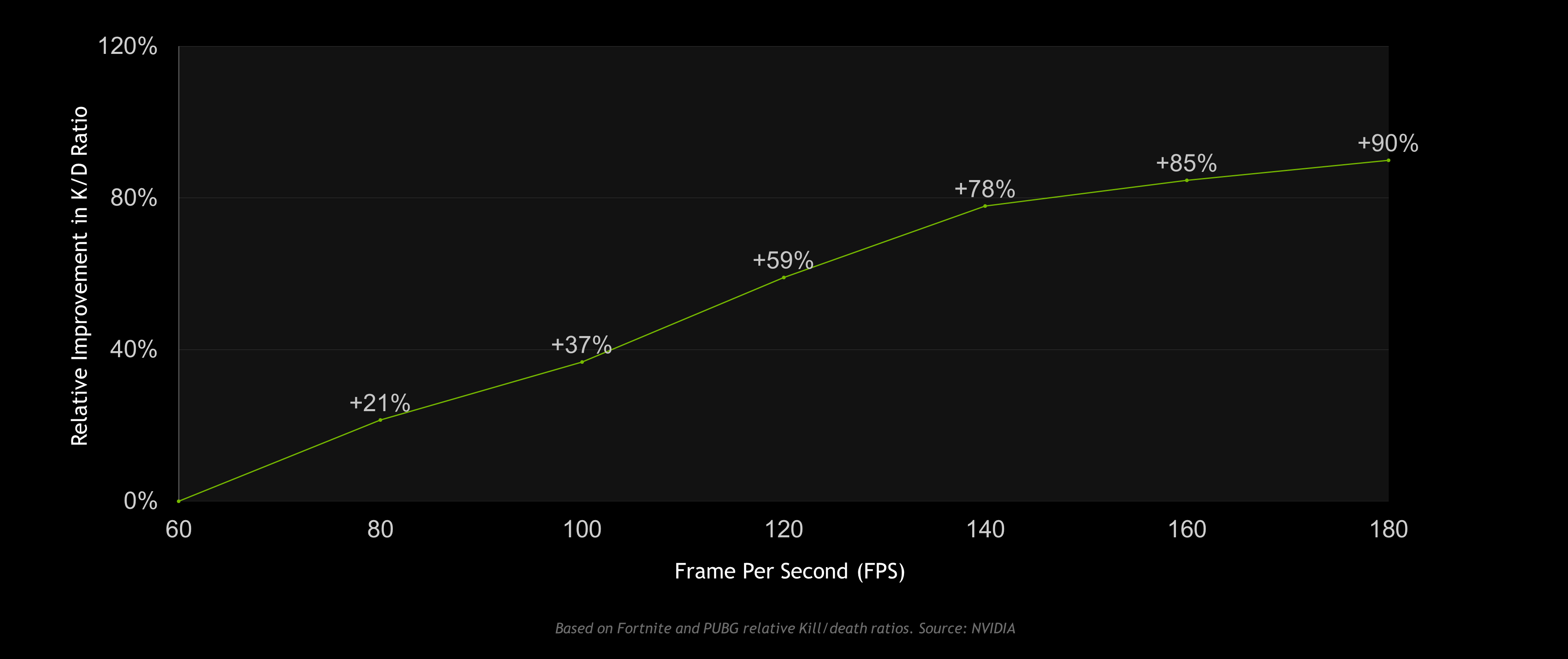

Führt dies also dazu tatsächlich zu erfolgreicherem Gaming? Zu einem guten Wettkampfschützen gehört viel mehr als nur mechanisches Geschick. Ein ausgeprägtes Gespür für das Spiel und eine kampferprobte Strategie können viel dazu beitragen, ob du das Spiel gewinnen kannst oder die Runde an dich geht. Betrachtet man jedoch unsere PUBG- und Fortnite-Daten, so sehen wir eine ähnliche Korrelation zwischen höheren FPS- (niedrigere Latenz) und Kill/Death-Raten.

Korrelation bedeutet aber keineswegs auch Kausalität. Überträgt man jedoch die genannten Forschungsergebnisse auf diese Korrelation, dann sehen wir eine Menge Beweise für die Behauptung, dass höhere FPS und niedrigere Systemlatenz zu besseren Trefferzahlen führen, wodurch die Kill/Death-Raten steigen.

Reduzieren der Systemlatenz mit NVIDIA Reflex

Mit der Einführung von NVIDIA Reflex haben wir uns zum Ziel gesetzt, hinsichtlich der Latenz jeden Aspekt der Rendering-Pipeline mit einer Kombination aus SDKs und Treiberoptimierungen zu optimieren. Einige dieser Verfahren können zu großen Latenzeinsparungen führen, während andere, je nach Situation, eher geringere Vorteile bieten. Unabhängig davon ist NVIDIA Reflex unser Versprechen, Spielern und Entwicklern Tools zur Optimierung der Systemlatenz zur Verfügung zu stellen.

NVIDIA Reflex SDK

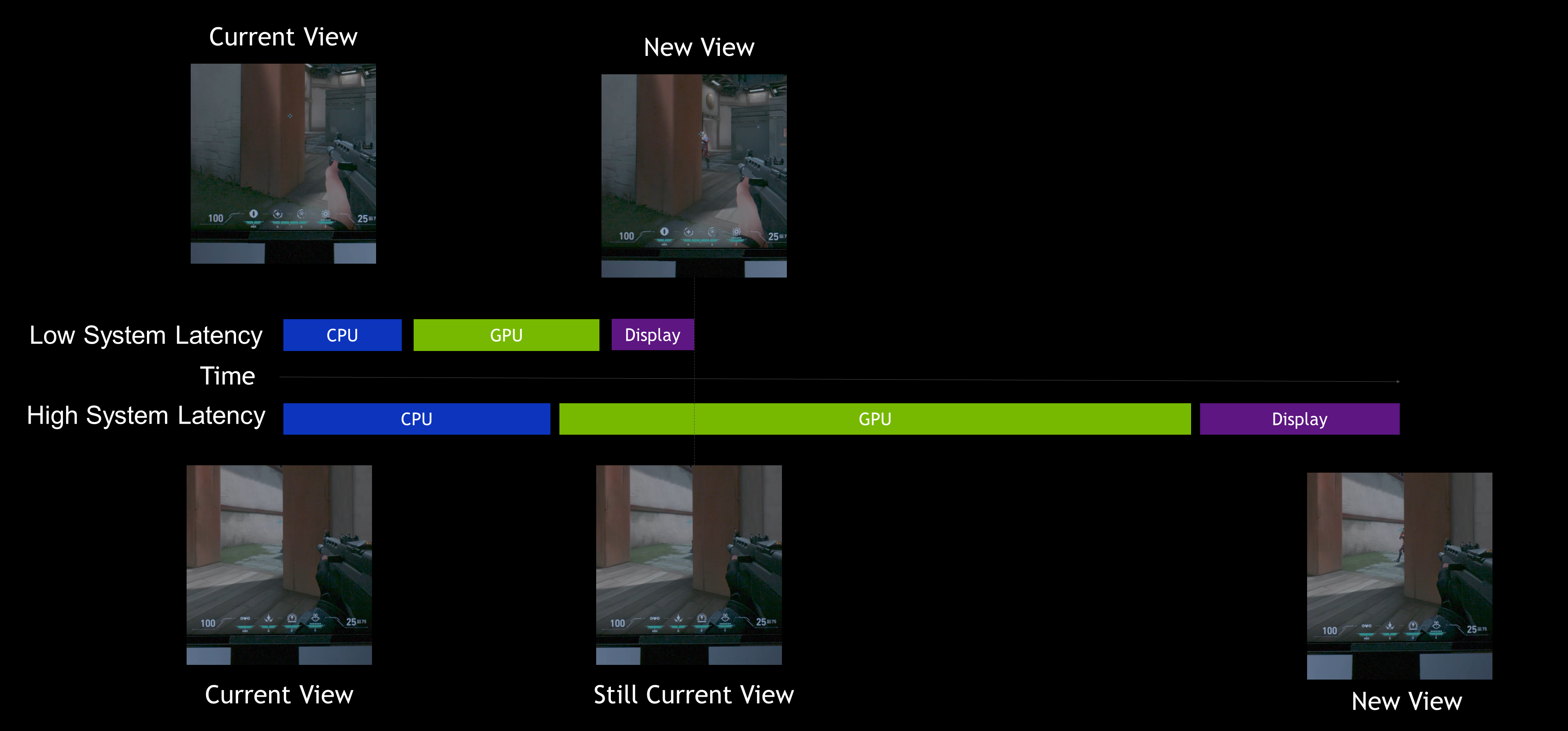

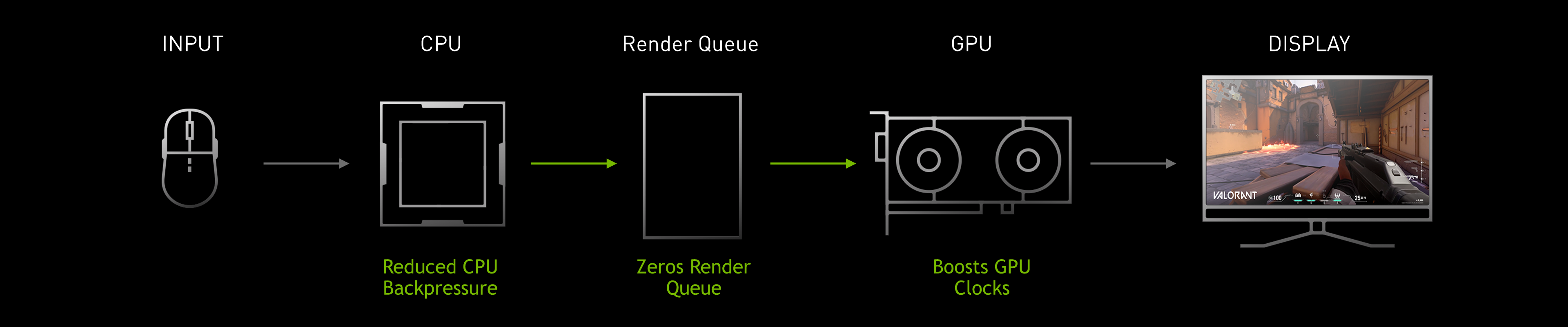

Reflex SDK ermöglicht es Spieleentwicklern, einen Niedriglatenzmodus zu implementieren, der die Arbeit der Spiele-Engine so ausrichtet, dass sie just-in-time mit dem Rendern fertig wird, wodurch die Warteschlange für das GPU-Rendering wegfällt und der CPU-Rückstau in GPU-gebundenen Szenarien reduziert wird.

In der vorigen Grafik können wir sehen, dass die Warteschlange mit Frames gefüllt ist. Die CPU verarbeitet Frames schneller, als die GPU sie rendern kann, was zu einer Zunahme der Rendering-Latenz führt. Reflex SDK teilt einige Ähnlichkeiten mit dem Ultra Low Latency-Modus im Treiber. Durch die direkte Integration in das Spiel sind wir jedoch in der Lage, die Länge des Rückstaus zu steuern, den die CPU aus der Rendering-Warteschlange und anderen späteren Stadien der Pipeline erhält. Beim Ultra Low Latency-Modus hat der Treiber viel weniger Kontrolle. Auch wenn der Ultra Low Latency-Modus häufig die Rendering-Warteschlange reduziert, so kann er den größeren Rückstau auf der Spiel- und CPU-Seite nicht beseitigen. Daher sind die Latenzvorteile von Reflex SDK im Allgemeinen viel besser als der Ultra Low Latency-Modus im Treiber.

Wenn Entwickler Reflex SDK integrieren, sind sie in der Lage, das Sampling von Eingaben und Spielsimulationen effektiv zu verzögern, indem sie den Zeitpunkt der Übermittlung der Rendering-Aufgaben an die GPU dynamisch anpassen, so dass diese just-in-time verarbeitet werden.

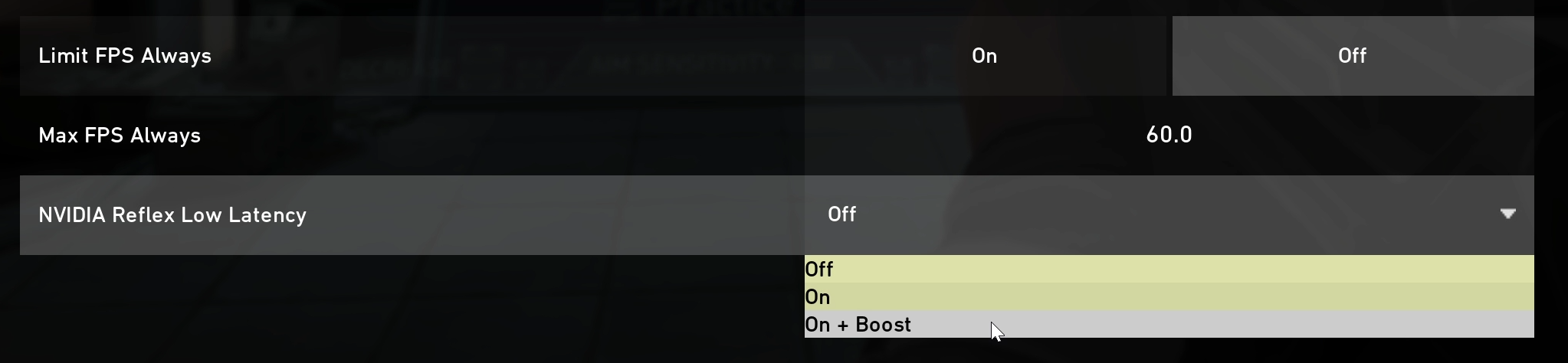

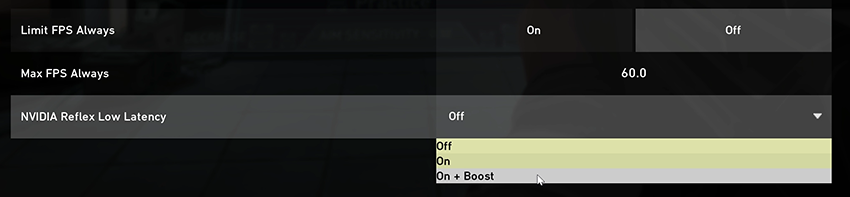

Darüber hinaus verfügt SDK über eine Funktion mit dem Namen Low Latency Boost. Diese Funktion setzt die Energiesparfunktionen des Grafikprozessors außer Kraft, damit die GPU-Taktung auch bei starker CPU-Belastung hoch bleiben kann. Selbst bei CPU-gebundenen Spielen führen längere Rendering-Zeiten zu zusätzlicher Latenz. Das Hochhalten der Taktfrequenz kann deutlich mehr Strom verbrauchen, aber auch die Latenzzeit etwas verringern, wenn die GPU deutlich unterausgelastet ist und die CPU die endgültigen Rendering-Aufgaben in großen Chargen abarbeitet. Du kannst den Reflex Low Latency-Modus übrigens auch ohne aktivierte Boost-Funktion nutzen, wenn du diesen Kompromiss hinsichtlich des Stromverbrauchs ablehnst.

Shooter-Spiele verhalten sich dynamisch – sie wechseln zwischen der Bindung an GPU und CPU hin und her. Im Falle einer Explosion mit vielen Partikeln hält Reflex SDK die Latenz bei einem GPU-gebundenen Spiel niedrig, indem es die GPU-Aufgaben nicht anstaut. Wenn das Rendering einfach und das Spiel CPU-gebunden ist, hält Reflex SDK die Latenz durch die Beibehaltung hoher GPU-Taktfrequenzen niedrig. Unabhängig vom Status der Rendering-Pipeline reduziert Reflex SDK die Rendering-Latenz für die vorgegebene Konfiguration auf intelligente Weise. Mit Reflex SDK können Spieler im Sweetspot der Rendering-Latenz bleiben, ohne alle Einstellungen auf Niedrig stellen zu müssen.

Zum Zeitpunkt dieser Reflex SDK-Ankündigung ist geplant, NVIDIA Reflex mit unserem nächsten, am XX. September 2020 erscheinenden Game Ready-Treiber bei folgenden Spielen zu implementieren: Apex Legends, Fortnite und VALORANT. Außerdem haben folgende Spiele den baldigen Einsatz von NVIDIA Reflex angekündigt: Call of Duty: Black Ops Cold War, Cuisine Royale, Destiny 2, Enlisted und Mordhau.

NVIDIA Reflex SDK unterstützt Grafikprozessoren bis hin zu den Produkten der GeForce GTX 900-Serie aus dem Jahr 2014. Der Low Latency Boost auf den GPUs der GeForce RTX 30-Serie wird jedoch eine etwas höhere Taktrate beibehalten, um die Latenz weiter zu reduzieren.

Für diejenigen, die sich ernsthaft damit befassen möchten, wie SDK funktioniert, werden wir die Rendering-Pipeline, die CPU/GPU-Bindung und die Reduzierung der Latenz im Abschnitt für Fortgeschrittene ausführlicher behandeln.

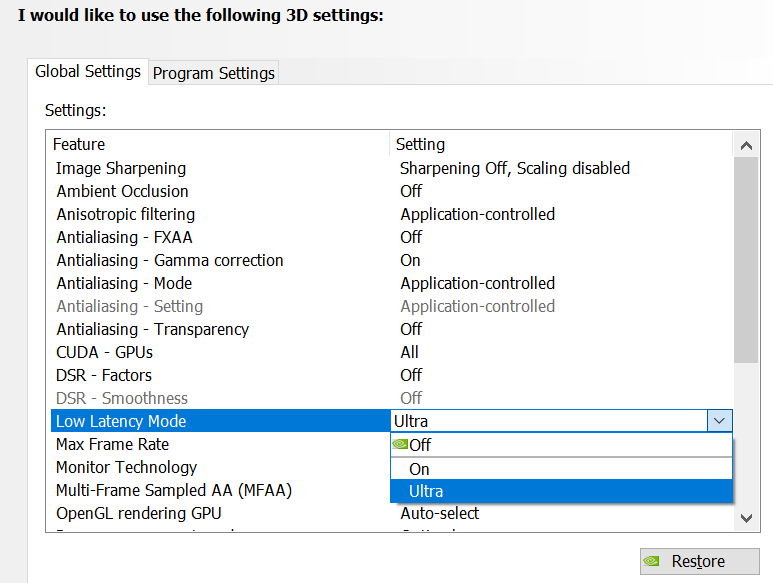

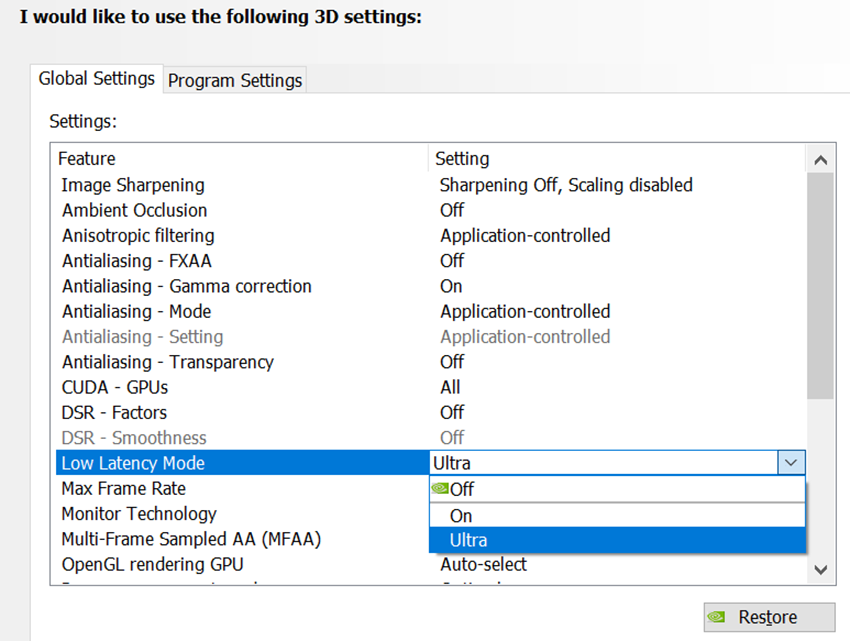

Ultra Low Latency-Modus

Wenn Reflex SDK ein Spiel nicht unterstützt, können dennoch partielle Latenzverbesserungen erzielen, indem der NVIDIA Ultra Low Latency-Modus über die NVIDIA Systemsteuerung aktiviert wird. Dazu öffnet man einfach das Bedienfeld, geht zu 3D-Einstellungen verwalten, dann zu Low Latency-Modus und wählt dort die Option Ultra. Wie bereits erwähnt, hilft dies, die Rendering-Latenz zu reduzieren, ohne die vollständige Kontrolle über die Pipeline zu haben.

Wenn ein Spiel den NVIDIA Reflex Low Latency-Modus unterstützt, empfehlen wir, diesen Modus über den Ultra Low Latency-Modus im Treiber zu aktivieren. Wenn jedoch beide eingeschaltet sind, hat der Reflex Low Latency-Modus automatisch eine höhere Priorität.

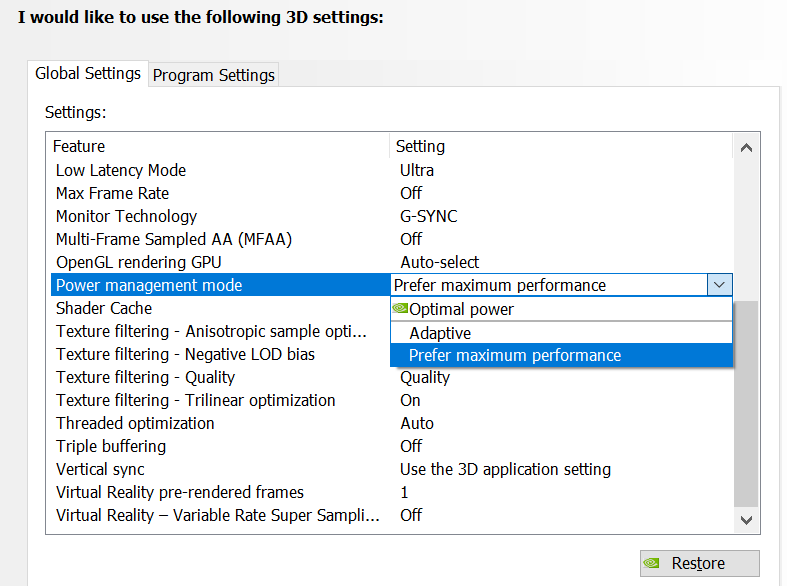

Bevorzugte Höchstleistung

Der NVIDIA-Grafiktreiber wird seit langem mit einer Option namens Power Management Mode (Energiemanagementmodus) ausgeliefert. Mit dieser Option können Gamer auswählen, wie der Grafikprozessor in CPU-gebundenen Szenarien funktioniert. Wenn der Grafikprozessor mit einer Aufgabe ausgelastet ist, läuft er immer mit maximaler Leistung. Wenn der Grafikprozessor jedoch nicht ausgelastet ist, besteht die Möglichkeit, Strom zu sparen, indem die GPU-Taktung reduziert wird, während die FPS-Rate beibehalten wird.

Ähnlich wie die Low Latency Boost-Funktion in Reflex SDK setzt der Modus für die bevorzugte Höchstleistung die Stromsparfunktionen im Grafikprozessor außer Kraft und ermöglicht es diesem, ständig mit höheren Taktraten zu arbeiten. Diese höheren Taktraten können die Latenzzeiten in CPU-gebundenen Instanzen verringern, wobei ein Kompromiss für einen höheren Stromverbrauch eingegangen wird. Dieser Modus ist für Gamer gedacht, die ohne Rücksicht auf den Energieverbrauch jede einzelne Mikrosekunde aus der Latenzpipeline herausholen möchten.

Bei den Grafikprozessoren der GeForce RTX 30-Serie können wir diesen Taktwert höher einstellen als bisher, sodass der Grafikprozessor die absolut niedrigste Rendering-Latenzzeit anstrebt, wenn er CPU-gebunden ist. Nutzer mit älteren GPUs können immer noch die Funktion der bevorzugten Höchstleistung aktivieren und die Taktung auf den Basisfrequenzen halten.

Automatisches Tuning in GeForce Experience

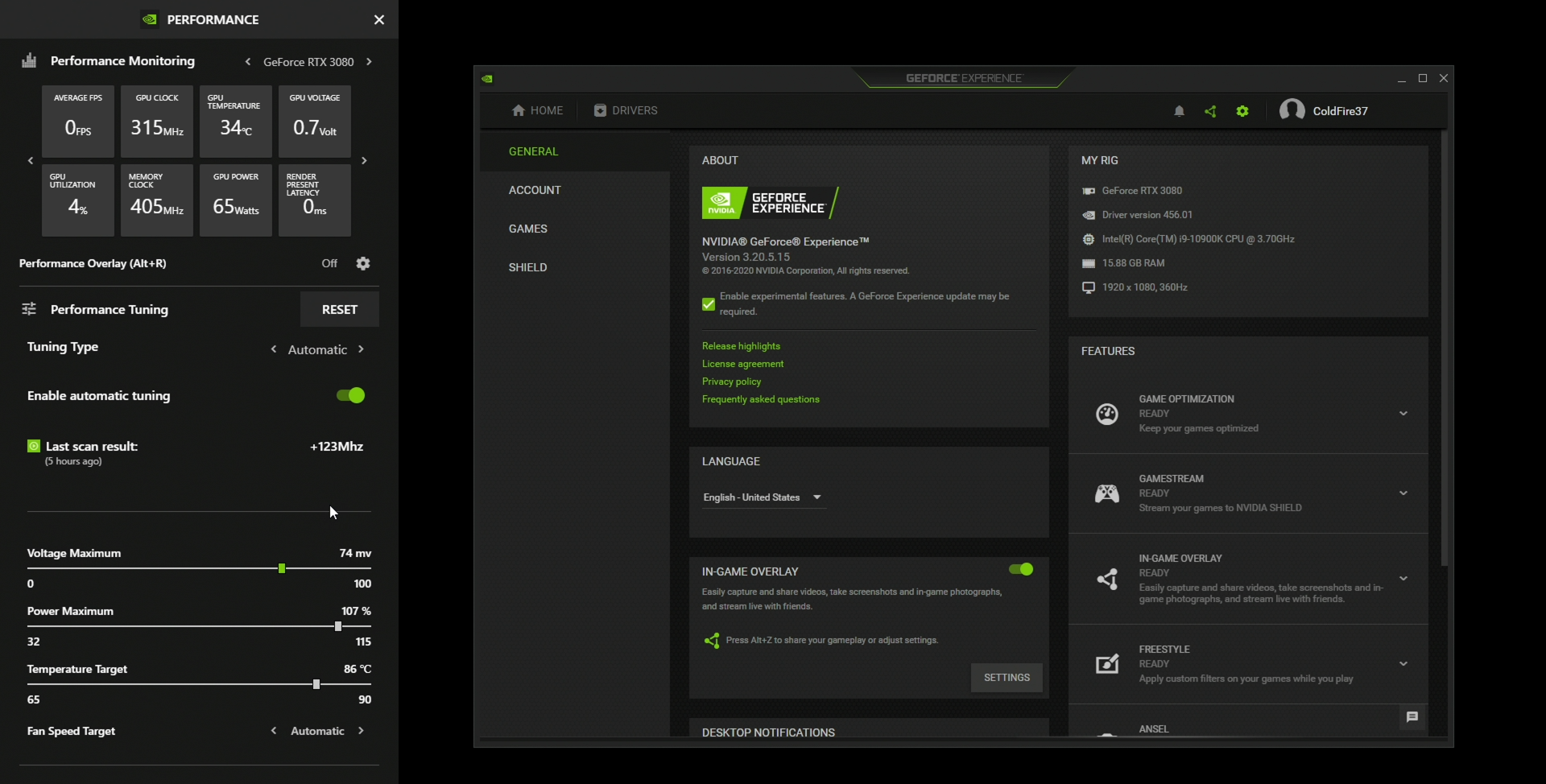

Mit der Veröffentlichung eines neuen GeForce Experience 17 September steht eine neue Beta-Funktion im In-Game-Overlay-Performance-Panel zur Verfügung, die es Gamern ermöglicht, ihren Grafikprozessor mit einem einzigen Klick auf eine niedrigere Rendering-Latenzzeit einzustellen.

Mit diesem neuartigen automatischen Tuner wird dein Grafikprozessor an jedem Spannungspunkt der Kurve auf die maximale Frequenzspitze überprüft. Sobald die perfekten Einstellungen für deinen Grafikprozessor gefunden und umgesetzt wurden, prüft der Tuner deine Abstimmung erneut und behält sie bei – so bleibt dein Tuning stabil.

Auf GeForce.com findest du immer die neuesten Informationen und Anleitungen für diese spannende neue Funktion.

Messung der Systemlatenz mit NVIDIA Reflex

Einer der Hauptgründe dafür, dass über die Systemlatenz bisher nicht viel gesprochen wurde, ist, dass es unglaublich schwierig war, sie genau zu messen. Um die Latenz zu messen, muss das Messgerät in der Lage sein, die Start- und Endzeit der Messung genau zu erfassen.

Bislang war die Messung der Systemlatenz nur mit teuren und komplizierten Hochgeschwindigkeitskameras, technischen Geräten und einer modifizierten Maus mit LED, die nachverfolgt, wann die Maustaste gedrückt wurde, möglich. Mit einer Hochgeschwindigkeitskamera mit 1000 FPS kannst du eine Latenzzeit ab 1 ms messen. Die Kosten für ein derartiges Setup beginnen allerdings bei etwa 7.000 $ für die bloße Mindestausrüstung. Selbst mit einer solchen Ausstattung dauert jede Messung etwa 3 Minuten. Für 99,9 % der Gamer ist das praktisch unmöglich.

NVIDIA Reflex Latency Analyzer

Kompatible G-SYNC-Bildschirme mit 360 Hz, die diesen Herbst auf den Markt kommen, sind mit einer neuen Funktion ausgestattet: dem NVIDIA Reflex Latency Analyzer. Diese revolutionäre Ergänzung ermöglicht es Gamern, die Reaktionsgeschwindigkeit des Systems zu messen, sodass sie die Leistung ihres PCs vollständig verstehen und optimieren können, bevor sie mit dem Gaming beginnen.

Um auf diese Funktion zuzugreifen, schließt du einfach deine Maus an den dafür vorgesehenen USB-Port des Reflex Latency Analyzer an einem 360 Hz-G-SYNC-Displays an. Der Reflex-USB-Anschluss des Displays ist ein einfacher Passthrough zum PC, der ohne zusätzliche Latenzzeit die Mausklicks beobachtet.

Der Reflex Latency Analyzer erkennt die von deiner Maus kommenden Klicks und misst die Zeit, die es dauert, bis die entsprechende Änderung der Anzeigepixel (wie Geschützfeuer) auf dem Bildschirm erfolgt. So erhältst du eine umfassende Messung der Systemlatenz.

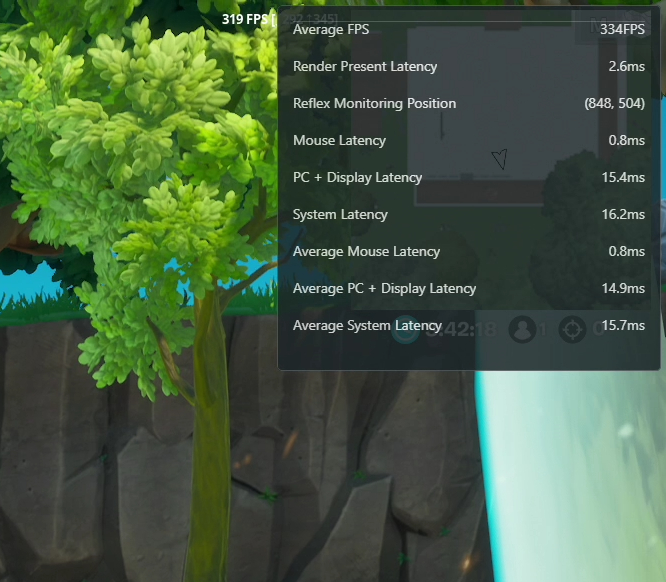

Das neue Performance Overlay von GeForce Experience zeigt die Latenzmessungen in Echtzeit an. Um die Latenzmessungen anzuzeigen, musst du zu den „Performance Overlay“-Optionen gehen und die Einstellung „Latency Metrics“ (Latenzmessungen) aktivieren (ab September verfügbar).

Der NVIDIA Reflex Latency Analyzer unterteilt die Messung der Systemlatenz in Mauslatenz, PC- und Displaylatenz und Systemlatenz.

Du kannst jede beliebige Maus mit dem Reflex Latency Analyzer verwenden, um die PC- und Display-Latenzzeit zu ermitteln (mit Ausnahme von Bluetooth-Mäusen). Mit einer kompatiblen Maus von Logitech, Razer oder ASUS kannst du jedoch auch die Peripherielatenz messen und die volle Ende-zu-Ende-Systemlatenz erhalten.

Außerdem werden wir eine offene Datenbank mit durchschnittlichen Mauslatenzen veröffentlichen, auf die zugegriffen werden kann, wenn GeForce Experience deine Maus erkennt. Künftig soll auch die Community in die Lage versetzt werden, Mäuse in die Datenbank aufzunehmen. Mehr dazu später.

Zum Zeitpunkt der Erstellung dieses Artikels gibt es drei Maushersteller, die ihre Unterstützung für den NVIDIA Reflex Latency Analyzer angekündigt haben: ASUS, Logitech und Razer. Behalte einfach deren Websites und Social Media-Auftritte im Auge, um keine Ankündigungen zur Kompatibilität des NVIDIA Reflex Latency Analyzers zu verpassen. Achte ab diesem Herbst auch auf 360 Hz-G-SYNC-Bildschirme von ASUS, ACER, Dell und MSI mit integrierter NVIDIA Reflex Latency Analyzer-Technologie.

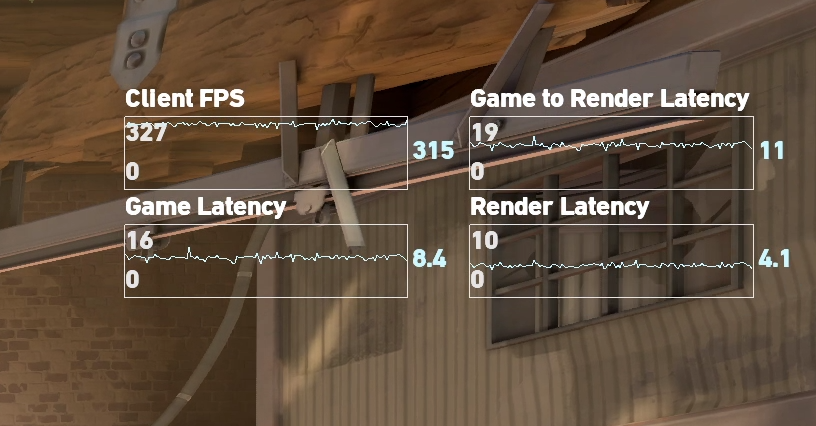

NVIDIA Reflex Softwarekennzahlen

Wenn du unbedingt vorher mit der Latenzmessung beginnen möchtest, kannst du dies auch tun, bevor du ein neues 360 Hz-Display in die Hände bekommst. Jedes Spiel, in das NVIDIA Reflex SDK integriert ist, bietet nämlich die Möglichkeit, sowohl die Spiele- als auch die Rendering-Latenzmessungen zu den In-Game-Statistiken hinzuzufügen. Bei dieser Messung handelt es sich nicht um die volle gefühlte Latenz, sondern um den Einstieg in die Optimierung von Latenzen.

Außerdem verfügt GeForce Experience jetzt über ein Performance Overlay, mit dem du die Rendering-Latenz in jedem Spiel nachverfolgen kannst. Die dargestellte Rendering-Latenz verfolgt den Aufruf durch die Rendering-Warteschlange und das GPU-Rendering. Da es sich um den letzten Aufruf eines Frames handelt, ist die Größe der dargestellten Rendering-Latenz zwar etwas kleiner als die Rendering-Latenz, die mit NVIDIA Reflex SDK gemessen wird, sollte dir aber dennoch eine gute Vorstellung von der Rendering-Latenz geben. Wir werden die Rendering-Latenz bei einem kommenden Update zu GeForce Experience hinzufügen.

Wenn die Funktion im Laufe dieses Monats veröffentlicht wird, musst du lediglich auf die neuesten Versionen des GeForce Game Ready-Treibers und GeForce Experience aktualisieren, das Menü „Performance“ (Leistung) auswählen, die Einstellung „Latency Metrics“ (Latenzmessungen) auswählen und das „Performance Overlay“ (Leistungs-Overlay) aktivieren.

Trainiere dein Ziel mit niedriger Latenz

Zusätzlich zu den Tools zur Latenzmessung haben wir uns mit The Meta, den Entwicklern von KovaaK 2.0, zusammengetan, um in einem zukünftigen Client-Update einen neuen NVIDIA Experimentiermodus einzuführen, mit dem Gamer ihre Leistung verbessern und ihre Fähigkeiten verfeinern können.

Du kannst den NVIDIA Experimentiermodus entweder über die Sandbox oder den Trainer aufrufen. Wenn du im NVIDIA Experimentiermodus bist, kannst du das Experiment auswählen, das dich interessiert. Darüber hinaus haben wir NVIDIA Reflex SDK in KovaaK 2.0 integriert, zusammen mit einigen anderen Technologien, mit denen Gamer den Unterschied zwischen hoher und niedriger Systemlatenz feststellen können.

Die Teilnahme an den Experimenten hilft nicht nur dir dabei, deine Zielgenauigkeit zu verbessern, sondern trägt auch zur E-Sports-Forschung bei. Unsere Partnerschaft mit The Meta bei KovaaK 2.0 ermöglicht es uns, bestimmte Mythen im kompetitiven Gaming-Bereich zu prüfen und damit aufzuräumen. Zum Beispiel versucht eines unserer ersten Experimente, die Vorlieben bei der Auswahl der Zielfarben mit ein paar wissenschaftlichen Erkenntnissen zu unterfüttern, die auf Diskussionen aufbauen, die Gamer in Bezug auf die Zielkonturfarben in VALORANT führen.

Bei anderen Experimenten sind beispielsweise schwierige Aufgaben bei unterschiedlichen Latenzvoraussetzungen zu erfüllen.Beobachte KovaaK 2.0 von The Meta auf Steam und bleibe dran, bis der NVIDIA-Experimentiermodus veröffentlicht wird.

Das nächste Level: Systemlatenz für Spezialisten

In Ordnung, dann öffnen wir mal die Motorhaube und sehen uns an, wie das alles auf dem nächsten Detaillevel läuft. Dieser Abschnitt befasst sich damit, wie deine Mausklicks tatsächlich zu den Pixeln auf deinem Bildschirm gelangen, dem Konzept der Game- und der Rendering-Pipelines, den Auswirkungen der CPU- und GPU-Bindung auf die Latenz, Überlappungen innerhalb der Rendering-Pipeline und schließlich mit einigen Tools zur Visualisierung der Vorgänge auf deinem System.

So kommen deine Aktionen aufs Display

Wie kommen deine Klicks also auf dein Display? In der folgenden Tabelle sind die Phasen der Pipeline aufgeschlüsselt. Dabei ist zu beachten, dass es zwar Überschneidungen zwischen diesen Phasen gibt, sie jedoch in der Reihenfolge von links nach rechts beginnen und enden müssen.

OK, lass uns jedes Kästchen in der zweiten Zeile des obigen Diagramms aufschlüsseln. Denk daran, dass die Größe der Kästchen nicht skalierbar ist. Außerdem werden wir uns der Einfachheit halber auf die Maus konzentrieren, aber alles Untenstehende gilt für jedes an den PC angeschlossene USB-Peripheriegerät.

- Maus-HW: Damit bezeichnet man den ersten elektrischen Kontakt, also wenn die Maus bereit ist, das Ereignis zu senden. In der Maus laufen ein paar Routinen (wie das Entprellen) ab, die deinem Mausklick eine Latenzzeit hinzufügen. Die Entprellungsroutinen sind wichtig und verhindern, dass die Maus klickt, wenn du es nicht möchtest. Diese zusätzlichen Klicks werden häufig als Doppelklicks bezeichnet, also wenn anstelle eines Klicks zwei Klicks gesendet werden, falls die Entprellungsroutine zu aggressiv war. Die Latenz ist also nicht das einzige wichtige Merkmal für die Leistung deiner Maus.

- Maus-USB-HW: Sobald die Entprellung abgeschlossen ist, muss die Maus auf das nächste Signal warten, um die Pakete zu verschicken. Diese Zeit spiegelt sich in der USB-HW wider.

- Maus-USB-SW: Die Maus-USB-SW ist die Zeit, die das Betriebssystem und der Maustreiber benötigen, um das USB-Paket zu verarbeiten.

- Sampling: Die Klicks gelangen basierend auf der Signalrate der Maus in das Betriebssystem, und müssen dann möglicherweise auf die nächste Gelegenheit warten, um vom Spiel gesampled zu werden. Diese Wartezeit wird als Sampling-Latenz bezeichnet. Diese Latenz kann je nach CPU-Framerate größer oder kleiner sein.

- Simulation: Games müssen ständig den Zustand der Spielewelt aktualisieren. Diese Aktualisierung wird häufig als Simulation bezeichnet. Die Simulation umfasst Dinge wie das Aktualisieren von Animationen, den Spielstatus und Änderungen aufgrund von Spielereingaben. Bei der Simulation werden deine Mauseingaben auf den Spielstatus umgesetzt.

- Rendering-Übermittlung: Wenn die Simulation erkennt, wo die Dinge im nächsten Frame platziert werden sollen, beginnt sie mit dem Senden der Rendering-Aufgaben an die Grafik-API-Runtime. Die Runtime wiederum gibt die Rendering-Befehle an den Grafiktreiber weiter.

- Grafiktreiber: Der Grafiktreiber ist für die Kommunikation mit dem Grafikprozessor und das Senden von Befehlsgruppierungen an die GPU verantwortlich. Je nach Grafik-API kann der Treiber diese Gruppierung für den Entwickler vornehmen, oder der Entwickler ist für die Gruppierung der Rendering-Aufgaben verantwortlich.

- Rendering-Warteschlange: Sobald der Treiber die Aufgabe zur Ausführung an die GPU schickt, wird sie in die Rendering-Warteschlange aufgenommen. Die Rendering-Warteschlange ist darauf ausgelegt, den Grafikprozessor ständig zu füttern, indem sie die Aufgaben für den Grafikprozessor puffert. Dadurch wird FPS (Durchsatz) maximiert, es können jedoch Latenzen auftreten.

- Rendering: Die Zeit, die die GPU benötigt, um die gesamte mit einem einzigen Frame verbundene Aufgabe zu rendern.

- Komposition Je nach Anzeigemodus (Vollbild, randlos, Fenster) muss der Desktop-Windows-Manager (DWM) im Betriebssystem zusätzliche Rendering-Aufgaben beauftragen, um den Rest des Desktops für einen bestimmten Frame aufzubauen. Dadurch können weitere Latenzzeiten entstehen. Es wird empfohlen, ausschließlich im Vollbildmodus zu bleiben, um die Kompositionslatenz zu minimieren.

- Scan-Out: Sobald die Komposition abgeschlossen ist, ist der endgültige Frame-Puffer anzeigebereit. Der Grafikprozessor signalisiert dann, dass der Frame-Puffer anzeigebereit ist, und legt fest, welcher Frame-Puffer aus dem Scan-Out ausgelesen wird. Wenn VSYNC eingeschaltet ist, kann dieser „Flip“ in den Frame-Puffern zum Stillstand kommen, da auf das VSYNC der Anzeige gewartet werden muss. Sobald der Grafikprozessor bereit ist, speist er den nächsten Frame Zeile für Zeile auf die Anzeige, je nach Bildwiederholrate (Hz) des Displays. Da der Scan-Out eine Funktion der Bildwiederholrate ist, zählen wir ihn zur Displaylatenz.

- Displayverarbeitung: Die Displayverarbeitung ist die Zeit, die das Display benötigt, um den eingehenden Frame (Scanlinien) zu verarbeiten und die Pixelantwort auszulösen.

- Pixelantwort: Das ist die Zeit, die ein Pixel benötigt, um von einer Farbe zur nächsten zu wechseln. Da Pixel eigentlich Flüssigkristalle sind, dauert es eine Zeit, bis sie sich verändern. Die Pixelantwortzeiten können je nach Intensität der erforderlichen Änderung variieren und hängen auch von der Steuerungstechnologie ab.

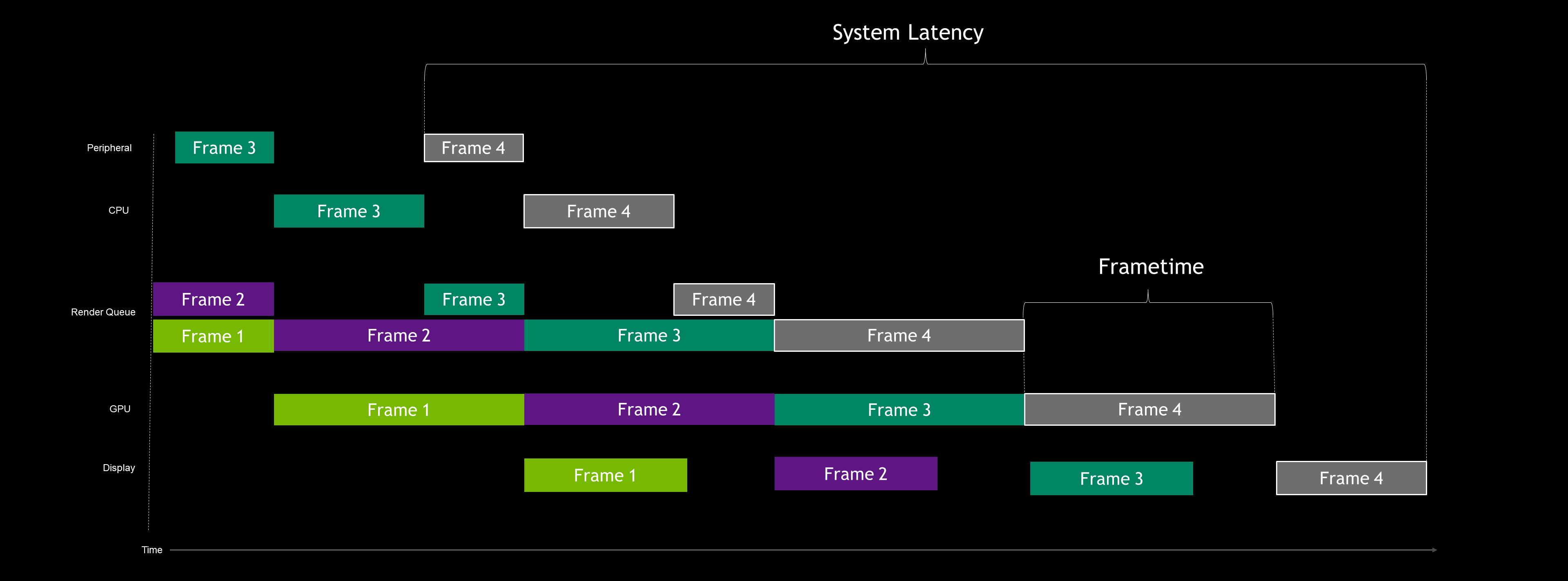

GPU-gebundene Latenzpipeline

Jetzt, da wir wissen, wie ein Klick auf den Bildschirm gelangt, wollen wir uns mit der Leistung befassen. Bei Spielebeschreibungen charakterisieren wir häufig die Leistung als GPU- oder CPU-gebunden. Das ist zwar äußerst hilfreich, um die Systemleistung zu verstehen, aber in der realen Welt springen Spiele häufig dazwischen hin und her.

Beginnen wir mit dem GPU-gebundenen Fall, wenn VSYNC ausgeschaltet ist.

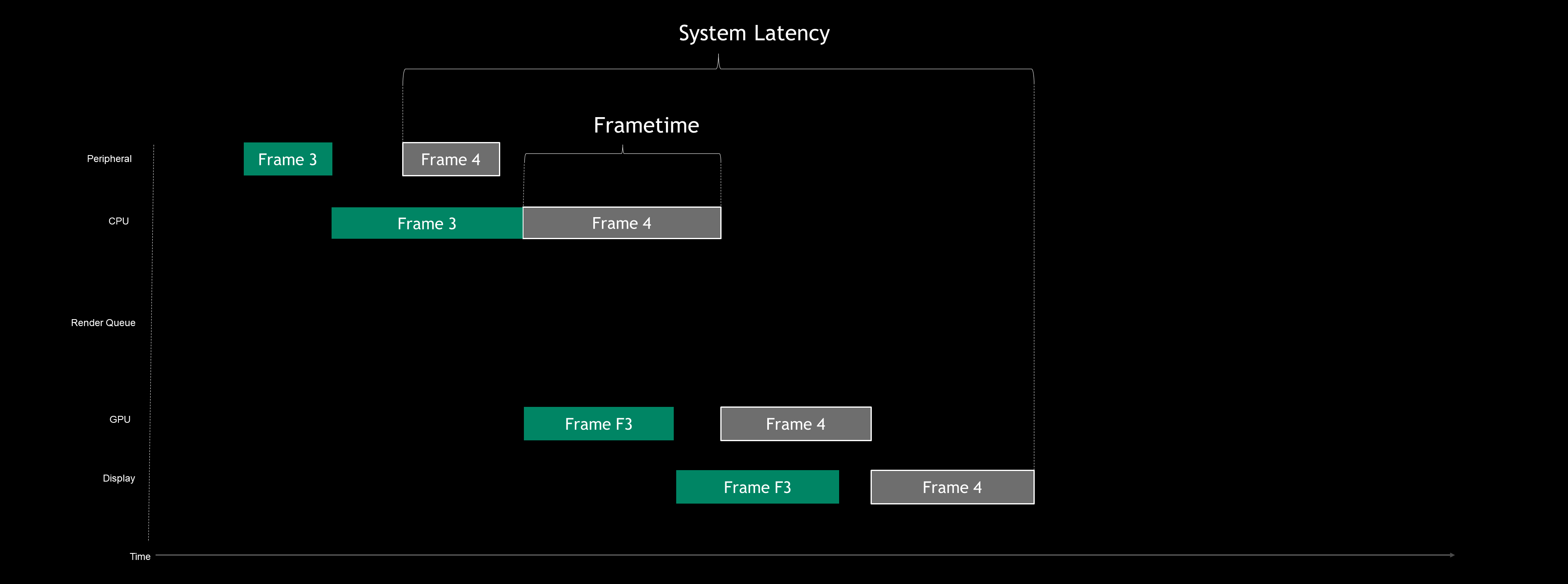

In diesem Beispiel vereinfachen wir die Pipeline auf fünf wichtige Phasen: Peripherie, CPU, Rendering-Warteschlange, GPU und Display.

Sehen wir uns Frame 4 an und untersuchen wir, was in den einzelnen Phasen vor sich geht:

- Peripherie: Maus- oder Tastatureingaben können jederzeit beginnen; die Entscheidung liegt beim Benutzer. In diesem Beispiel wurde die Maus angeklickt, bevor die CPU bereit war, die Eingabe zu verarbeiten, sodass das Eingabeereignis nur wartet. Es ist sozusagen am Bahnhof eingetroffen und wartet nun auf den nächsten Zug.

- CPU: Der Start der CPU (Simulation) beginnt in der Regel, nachdem ein so genannter Present-Block beendet ist. Im GPU-gebundenen Fall führt die CPU ihre Arbeit schneller aus, was bedeutet, dass sie vor der GPU laufen kann. In den meisten Grafik-APIs (DX11, DX12, Vulkan usw.) ist jedoch die Anzahl der Frames begrenzt, die der Thread für die CPU-Rendering-Übermittlung vorauslaufen kann. Im obigen Fall darf die CPU zwei Frames vorauslaufen. Der CPU-Abschnitt wird beendet, wenn der Treiber mit der Übermittlung der Aufgabe an die GPU fertig ist. In Wirklichkeit gibt es Überschneidungen mit der Rendering-Warteschlange, aber darauf wir werden später eingehen.

- Rendering-Warteschlange: Das kannst du dir wie jede andere Reihe oder Warteschlange vorstellen. Wer als Erster in der Schlange steht, ist als Erster wieder draußen. Falls die GPU noch am vorherigen Frame arbeitet, wenn die CPU weitere Aufgaben übermittelt, dann stellt die CPU diese Rendering-Aufgabe in die Rendering-Warteschlange. Diese Warteschlange kann hilfreich sein, um sicherzustellen, dass die GPU ständig gespeist wird, und sie kann dazu beitragen, die Framezeiten zu glätten, aber sie kann auch erhebliche Latenzzeiten verursachen.

- GPU: Hierbei handelt es sich um das tatsächliche GPU-Rendering des Frames. Im GPU-gebundenen Fall folgen die Aufgaben direkt aufeinander, da die GPU die Komponente ist, die den Engpass darstellt.

- Display: Dies ist der Fall, wenn VSYNC ausgeschaltet ist. Wenn die GPU das Rendern beendet hat, scannt sie sofort den neuen Puffer aus, unabhängig davon, an welcher Stelle im Scan-Prozess sich das Display befindet. Dies erzeugt Tearing, wird aber von Gamern häufig bevorzugt, weil es die geringste Latenzzeit bietet. Bald folgt ein Artikel über VSYNC und G-SYNC. Bleib dran!

In Ordnung, jetzt, da wir verstehen, was hier vor sich geht, können wir erkennen, dass es Engpässe bei der GPU gibt, die dazu führen, dass sich die Rendering-Warteschlange staut und die CPU vorwegläuft. In der obigen Abbildung sehen wir, dass unsere Framedauer die FPS-Messung ist. In diesem Fall würde ein schnellerer Grafikprozessor eine höhere Framerate erzeugen.

Außerdem können wir die Systemlatenz sehen, beginnend mit dem ersten Mausklick bis zur Fertigstellung der Anzeige. Die Latenzzeit ist in der Regel in GPU-gebundenen Fällen höher, da die Rendering-Warteschlange und das Spiel vor dem Present-Block laufen und neue Frames generieren, deren Übermittlung dann verzögert wird.

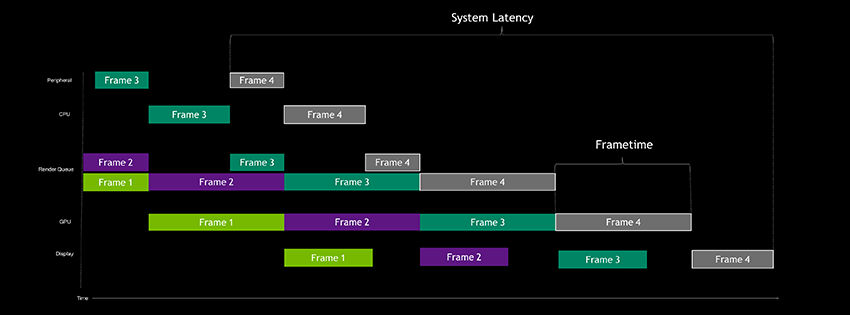

NVIDIA Reflex SDK-Latenzpipeline

Sehen wir uns nun an, was NVIDIA Reflex SDK mit der GPU-gebundenen Pipeline macht:

Wie du sehen kannst, ist die Rendering-Warteschlange so gut wie verschwunden. Reflex SDK deaktiviert sie aber nicht, sondern entleert sie nur. Aber wie funktioniert das?

Im Wesentlichen kann das Spiel die CPU besser anzupassen, sodass sie nicht mehr voraus laufen kann. Außerdem können die Aufgaben rechtzeitig an die GPU gesendet werden, damit diese ohne Leerlauflücken in ihrer Aufgabenpipeline arbeiten kann. Durch den späteren Start der CPU-Arbeit besteht außerdem die Möglichkeit, Eingaben in der letztmöglichen Millisekunde zu samplen, wodurch die Latenzzeit weiter reduziert wird.

Wenn die Rendering-Warteschlange mit der von SDK verwendeten Methode verkürzt wird, verringert sich auch die Spielelatenz. Diese Verringerungen sind auf den Abbau des Rückstaus zurückzuführen, der durch die Rendering-Warteschlange in GPU-gebundenen Szenarien verursacht wird.

Diejenigen unter euch, die schon einmal Latenzoptimierungen durchgeführt haben, wissen, dass dies wie die Verwendung eines guten In-Game-Frameratenbegrenzers zur Latenzverringerung beiträgt. Gute In-Game-Frameratenbegrenzer halten das Spiel an den richtigen Stellen an, was für eine niedrigere Latenz und weniger Rückstau an der CPU sorgt.

Da NVIDIA Reflex jedoch nicht an eine bestimmte Framerate gebunden ist, kann die Framerate schneller als dein Limit laufen und die Latenz weiter verringern. Man kann sich das als einen „dynamischen“ Frameratenbegrenzer vorstellen, der die Latenz jederzeit im Sweetspot hält.

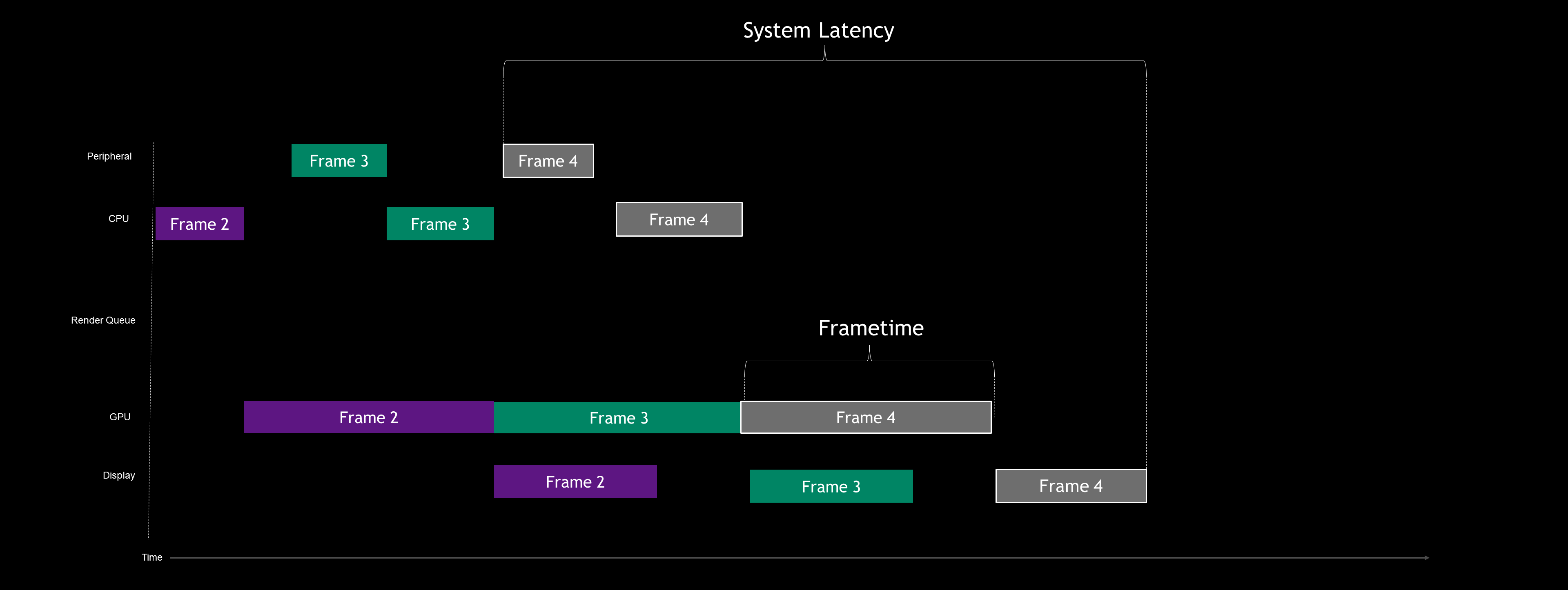

CPU-gebundene Latenzpipeline

Bei Verwendung des Reflex Low Latency-Modus in einem GPU-gebundenen Fall verhält sich die Pipeline so, als wäre sie CPU-gebunden, auch wenn die GPU komplett ausgelastet ist. Schauen wir uns einmal an, wie eine tatsächliche CPU-gebundene Pipeline aussieht.

Wie du in diesem Diagramm sehen kannst, ist die Framerate durch die CPU begrenzt. Da die CPU der GPU nicht voraus laufen kann, gibt es in diesem Fall auch keine Rendering-Warteschlange. Im Allgemeinen hat ein CPU-gebundener Fall eine niedrigere Latenzzeit als ein GPU-gebundener.

In diesem Fall führt ein schnellerer Grafikprozessor keine zusätzlichen FPS aus, verringert aber die Latenz. Wenn VSYNC ausgeschaltet oder G-Sync aktiviert ist, bedeutet ein schnellerer Grafikprozessor, dass das gerenderte Bild schneller an das Display gesendet werden kann.

Wenn du dich jemals gefragt hast, warum ein Spiel nach dem Herabsetzen deiner Einstellungen schneller reagiert, dann hast du hier den Grund dafür. Durch das Herabsetzen der Einstellungen kann häufig ein CPU-gebundenes Szenario erstellt (Eliminierung der Warteschlange) und gleichzeitig die GPU-Renderzeit reduziert werden, wodurch die Latenzzeit weiter verringert wird.

Mit dem Reflex Low Latency-Modus müssen Spieler ihre Einstellungen nicht standardmäßig ganz herunterregeln. Da wir die Rendering-Warteschlange effektiv reduzieren können, steigern weitere Rendering-Aufgaben lediglich die Renderzeit der GPU.

Außerdem verfügt selbst bei einer CPU-Bindung der Reflex Low Latency-Modus über eine Boost-Einstellung, die Stromsparfunktionen zugunsten einer leicht verringerten Latenz deaktiviert. In CPU-gebundenen Fällen, bei denen die GPU-Auslastung gering ist, werden die GPU-Taktraten hoch gehalten, um die Verarbeitung zu beschleunigen, so dass ein Frame so schnell wie möglich an das Display geliefert werden kann. Im Allgemeinen bietet diese Boost-Einstellung nur sehr geringe Vorteile, kann aber dazu beitragen, auch die letzte Millisekunde aus der Latenzpipeline herauszuquetschen.

Computerlatenz und Überlappung

Wollen wir noch ein Level tiefer steigen? Wir wollen einen Blick auf einen Einzelframe werfen, aber diesmal betrachten wir die Pipeline mit voller Überlappung.

Wie du siehst, erfolgen die meisten Überlappungen im Kern der PC-Latenz zwischen der Simulation und dem Abschluss des GPU-Renderings. Aber warum ist das so?

Frames werden in kleinen Stücken, sogenannten Draw Calls, gerendert. Diese Calls werden abschließend in Aufgabenpaketen zusammengefasst. Die Aufgabenpakete werden dann vom Grafiktreiber an den Grafikprozessor gesendet, wo sie gerendert werden. Auf diese Weise kann jede der Phasen mit der Arbeit beginnen, bevor die vorherige Phase abgeschlossen ist. Der Frame wird also in mundgerechte Stücke zerlegt.

Wenn die Aufgabe den Weg durch die Pipeline beendet hat, wird sie schließlich in den Frame-Puffer geschrieben. Dieser Vorgang wird fortgesetzt, bis der Frame vollständig gerendert wurde. Sobald das Rendern abgeschlossen ist, wird der Hintergrundpuffer gegen einen anderen verfügbaren Puffer in der Warteschlange ausgetauscht und zum Out-Scan gesendet.

Dies zu verstehen ist wichtig, wenn man die Rendering-Latenz und die Spielelatenz betrachtet. Häufig überlappen sich Spiele-Latenzen und Rendering-Latenzen, was bedeutet, dass das einfache Aufsummieren der Latenzen nicht die korrekte Latenzsumme ergibt.

Zusammenfassung

Die Systemlatenz ist sowohl ein quantitatives Maß dafür, wie sich dein Spiel anfühlt, als auch der Schlüsselfaktor, der die Zielgenauigkeit der Spieler bei Ego-Shootern beeinflusst. NVIDIA Reflex ermöglicht Entwicklern und Spielern die Optimierung der Systemlatenz und bietet erstmals die Möglichkeit, diese auf einfache Weise zu messen.

Zusammenfassend lässt sich sagen, dass NVIDIA Reflex eine vollständige Sammlung an Latenztechnologien beinhaltet:

- Low Latency-Technologie:

- NVIDIA Reflex SDK-Metriken: Spiele- und Rendering-Latenzmarker ermöglichen es Entwicklern, Latenzmetriken im Spiel anzuzeigen

- NVIDIA Reflex Latency Analyser: Eine neue Funktion der 360 Hz-G-SYNC-Displays, die erstmals eine vollständige Messung der Ende-zu-Ende-Systemlatenz ermöglicht

- GeForce Experience-Leistungstunin: Seitenleisten- und In-Game-Überlappung zur Echtzeitanzeige von Leistungsmetriken, einschließlich der Latenz

- Tools zur Latenzmessung:

- NVIDIA Reflex SDK-Metriken: Spiele- und Rendering-Latenzmarker ermöglichen es Entwicklern, Latenzmetriken im Spiel anzuzeigen

- NVIDIA Reflex Latency Analyser: Eine neue Funktion der 360 Hz-G-SYNC-Displays, die erstmals eine vollständige Messung der Ende-zu-Ende-Systemlatenz ermöglicht

- GeForce Experience-Leistungsüberwachung: Seitenleisten- und In-Game-Überlappung zur Echtzeitanzeige von Leistungsmetriken, einschließlich der Latenz

Wir freuen uns, dir NVIDIA Reflex anbieten zu können und dir damit ein reaktionsschnelleres Spielerlebnis zu ermöglichen. Wir bei NVIDIA konzentrieren uns auf die Reduzierung der Latenzzeiten und werden NVIDIA Reflex weiter verfeinern und unser Partner-Ökosystem erweitern.

Wir freuen uns auf dein Feedback! Besuche das Reflex-Community-Forum, wo du dich über Latenzzeiten austauschen oder Fragen über die NVIDIA Reflex-Plattform stellen kannst.

Die Treiberunterstützung für den NVIDIA Reflex Low Latency-Modus wird mit dem Game Ready-Treiber am XX. September veröffentlicht, und unsere Partner werden ihre Games im Laufe des Jahres damit ausrüsten. Die G-Sync-Gaming-Monitore mit 360 Hz von Acer, Asus, Dell und MSI werden ab Herbst dieses Jahres lieferbar sein.