NVIDIA EGX™ 플랫폼에는 인프라 전반에 걸쳐 컴퓨팅을 가속화하는 최적화된 소프트웨어가 포함되어 있습니다. NVIDIA AI Enterprise를 사용하는 기업은 NVIDIA-Certified Systems를 통해 VMware vSphere에서 실행되도록 NVIDIA가 최적화, 인증, 지원하는 AI 및 데이터 분석 소프트웨어의 엔드 투 엔드 클라우드 네이티브 제품군에 액세스할 수 있습니다. NVIDIA AI Enterprise에는 최신 하이브리드 클라우드에서 AI 워크로드의 빠른 배포, 관리 및 확장을 지원하는 NVIDIA의 주요 기반 기술이 포함되어 있습니다.

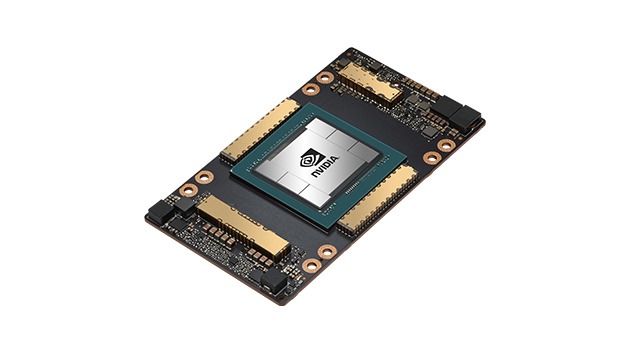

NVIDIA A100 Tensor 코어 GPU

모든 규모에서의 유례 없는 가속화